Google Gemini : Évaluer, auditer et maîtriser le modèle d'IA de Google

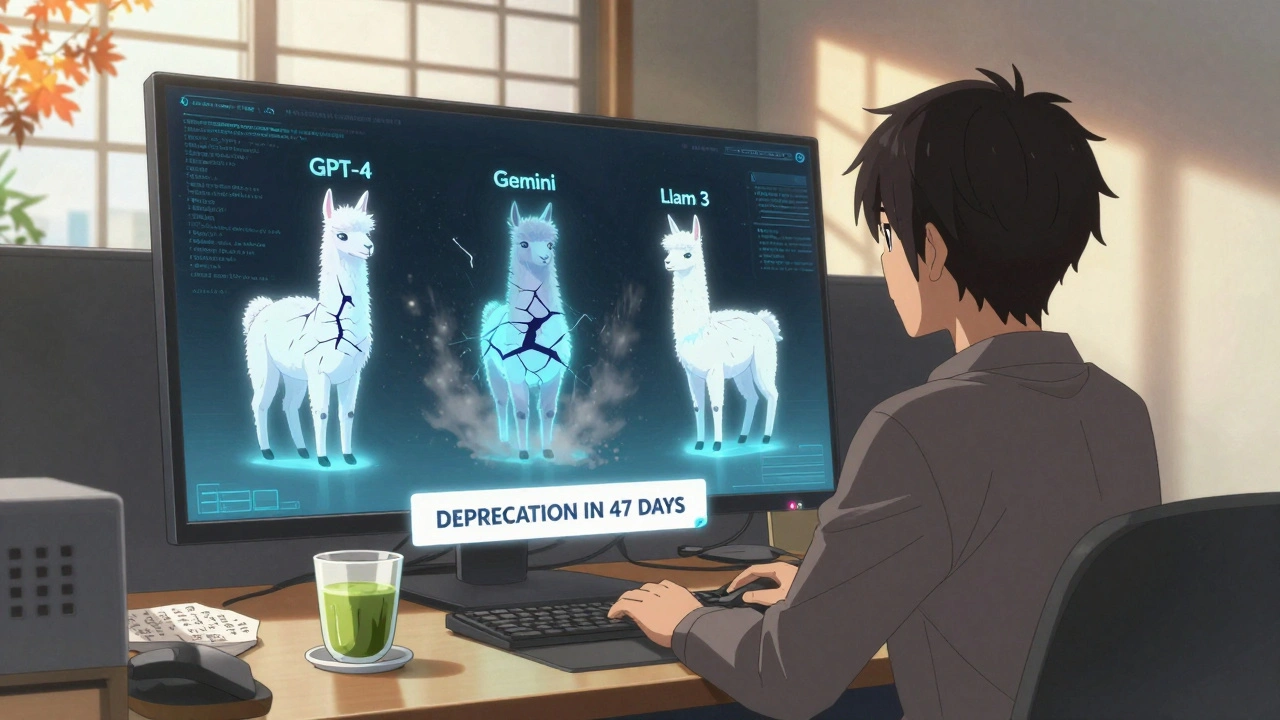

Quand on parle de Google Gemini, un modèle d'intelligence artificielle multimodal développé par Google pour rivaliser avec les grands modèles de langage comme GPT-4 ou Llama 3. Il est aussi connu sous le nom de Gemini 1.5 ou Gemini Pro, et il est conçu pour traiter à la fois du texte, des images, des vidéos et même du code. Mais ce n’est pas parce qu’il est puissant qu’il est fiable — c’est là que l’évaluation entre en jeu.

Beaucoup pensent que si un modèle est de Google, il est automatiquement sûr, précis et éthique. Ce n’est pas vrai. Les benchmarks, des jeux de tests standardisés comme MMLU, LiveBench ou HumanEval révèlent que Google Gemini peut performer excellent sur des tâches générales, mais tombe souvent en défaut sur des questions nuancées, des raisonnements logiques ou des contextes multilingues. Et si vous l’utilisez dans un service client, une application médicale ou un outil juridique, ces échecs peuvent coûter cher. C’est pourquoi les audits IA, des vérifications systématiques de la sécurité, de la biais et de la traçabilité des réponses, sont devenus indispensables. Sans eux, vous n’avez pas un modèle fiable — vous avez un black box avec une belle interface.

Les équipes qui utilisent Google Gemini en production savent qu’il ne s’agit pas juste de choisir le modèle le plus rapide ou le moins cher. Il faut comprendre comment il réagit à des instructions ambiguës, des prompts mal formulés qui déclenchent des hallucinations ou des réponses factuellement fausses. Il faut aussi connaître ses limites dans des langues autres que l’anglais, ses biais culturels, et comment il réagit quand on le pousse à générer du code ou à résumer des documents sensibles. Ce sont ces détails — invisibles dans les présentations marketing — qui déterminent si vous réussissez ou si vous vous exposez à un risque.

Vous trouverez ici des articles concrets sur la façon de tester Google Gemini contre des scénarios réels, comment l’intégrer dans des workflows avec human-in-the-loop, et comment éviter les pièges courants quand on le compare à d’autres modèles comme Claude ou Llama. Pas de théorie abstraite. Pas de promesses vides. Juste des méthodes, des checklists, et des retours d’expérience de ceux qui l’utilisent déjà en production.