Un modèle d’intelligence artificielle qui fonctionne bien aujourd’hui ne fonctionnera pas bien demain. C’est une vérité simple, mais souvent ignorée. Beaucoup pensent que déployer un modèle de machine learning, c’est finir un projet. En réalité, c’est juste le début. Ce qui compte, c’est ce qui se passe après le déploiement. Comment le modèle réagit-il aux données nouvelles ? Les utilisateurs changent-ils de comportement ? Les tendances évoluent-elles ? Si vous ne répondez pas à ces questions, votre IA devient une ancienne technologie en production - et elle commence à faire des erreurs, souvent discrètes, mais coûteuses.

Le cycle invisible qui garde l’IA vivante

Les boucles d’amélioration continue ne sont pas une fonctionnalité optionnelle. C’est le système nerveux de toute IA opérationnelle. Imaginez un système qui prédit les pannes d’équipement dans une usine. Il a été formé sur des données de l’année dernière. Mais cette année, les fournisseurs ont changé, les pièces sont différentes, les températures ambiantes ont augmenté. Le modèle, sans mise à jour, continue de faire des prédictions basées sur des données obsolètes. Il commence à sous-estimer les risques. Des pannes surviennent. Des coûts s’accumulent.

C’est là que la boucle entre en jeu. Elle fonctionne en quatre étapes répétées sans fin : recueillir, analyser, adapter, valider. Chaque prédiction du modèle devient une opportunité d’apprentissage. Si un technicien rejette une alerte générée par le système, cette décision est enregistrée. Si un client modifie son comportement d’achat en réponse à une recommandation, cette interaction est capturée. Ces données ne sont pas des bruits - ce sont des leçons.

Ce cycle est ce qu’on appelle le feedback loop - une boucle de rétroaction. Elle transforme l’IA d’un système statique en un système vivant. Ce n’est pas une amélioration ponctuelle. C’est un apprentissage continu. Et il ne fonctionne que si chaque étape est automatisée et documentée.

Le rôle du feedback humain et machine

Le feedback ne vient pas seulement des données. Il vient aussi des gens. Un modèle de chatbot peut générer une réponse incorrecte. Un utilisateur la signale. Cette action simple - cliquer sur « Cette réponse est inexacte » - est une donnée précieuse. Elle dit au système : « Tu t’es trompé ici. Voici comment tu devrais réagir. »

Les systèmes les plus performants intègrent ce type de feedback de manière fluide. Par exemple, l’application C3 AI Reliability permet aux opérateurs de rejeter les recommandations de maintenance. Si un technicien choisit de ne pas suivre une alerte, il peut noter la raison : « Le capteur était défectueux », ou « Le bruit était normal ». Ces notes sont ensuite utilisées pour réentraîner le modèle. Le système apprend non seulement de ses erreurs, mais aussi de la sagesse humaine.

Le feedback machine, lui, vient des métriques de performance. L’exactitude, la précision, le rappel, la latence - chaque mesure est un signal. Quand un modèle commence à dériver - c’est-à-dire qu’il produit des résultats de plus en plus éloignés de la réalité - les alertes automatiques déclenchent un retraining. Pas un retraining manuel. Pas une révision trimestrielle. Un retraining automatique, déclenché par des seuils définis. Par exemple : si la précision tombe en dessous de 92 % pendant 48 heures, le pipeline de retraining démarre sans intervention humaine.

Le retraining : plus qu’une mise à jour

Beaucoup confondent retraining et mise à jour logicielle. Ce n’est pas la même chose. Une mise à jour logicielle, c’est comme changer un pneu. Le retraining, c’est comme apprendre à conduire à nouveau après un accident. Vous ne réparez pas le modèle. Vous le reformez.

Le retraining automatique ne fonctionne pas avec n’importe quelles données. Il nécessite une architecture rigoureuse. Les données doivent être nettoyées, étiquetées, et comparées aux données d’origine. Des tests de drift sont exécutés : est-ce que les nouvelles données ressemblent encore aux données d’entraînement ? Si la distribution des données change trop - par exemple, si 70 % des nouveaux utilisateurs viennent d’un nouveau marché - le modèle ne peut plus se fier à ses anciennes règles. Il doit être réentraîné.

Les meilleures pratiques recommandent d’utiliser des jeux de données « golden » - des jeux de référence fiables - pour évaluer la qualité du retraining. Avant de déployer un nouveau modèle, on le teste sur ces jeux-là. Si ses performances sont inférieures à celles du modèle actuel, il est rejeté. Pas de risque. Pas de dégradation. Juste une amélioration vérifiée.

Les invites : le langage des modèles génératifs

Dans les modèles génératifs - comme les chatbots ou les outils de rédaction automatisée - le feedback ne vient pas seulement des résultats. Il vient aussi des invites (prompts). Une invite mal conçue donne une réponse inutile. Une invite bien formulée donne une réponse précise, structurée, utile.

Les équipes qui maîtrisent l’amélioration continue des modèles génératifs ne se contentent pas de tester des invites une fois. Elles les optimisent en boucle. Chaque interaction est enregistrée. Quand un utilisateur modifie une réponse générée, cette modification devient un nouvel exemple. Quand un client demande une réponse plus courte, plus directe, ce besoin est codifié dans la prochaine version de l’invite.

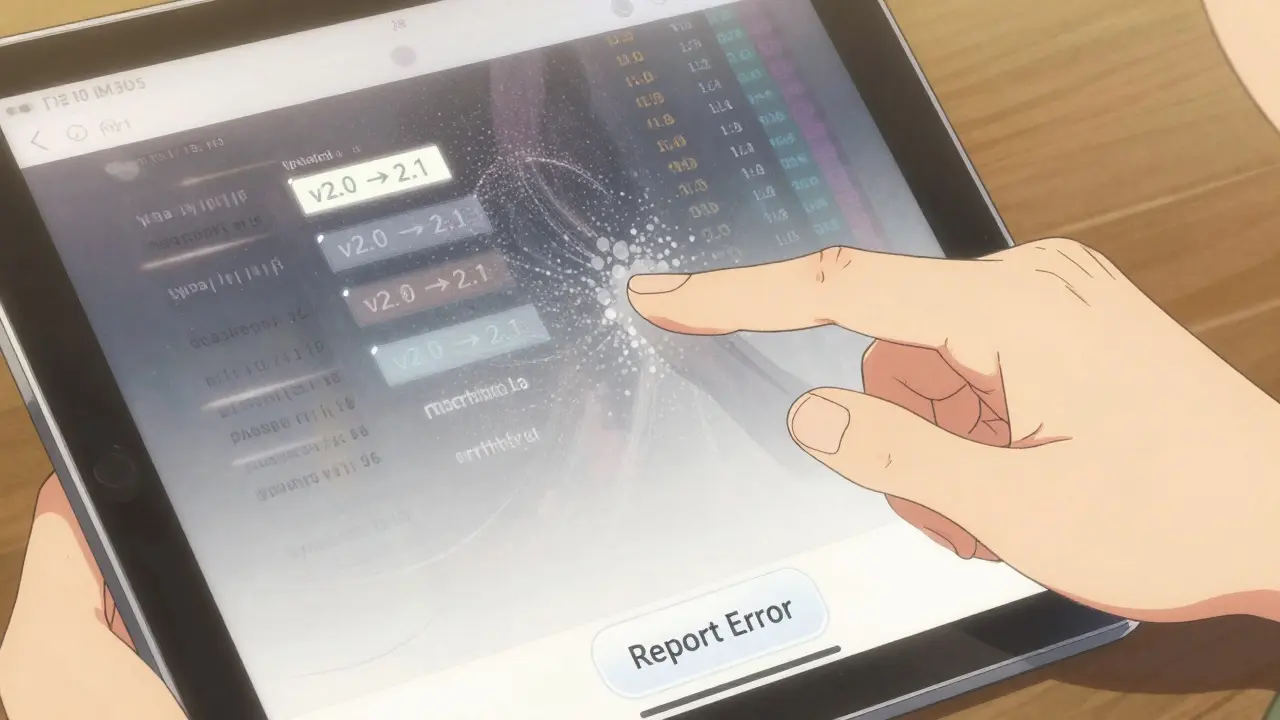

Les meilleures entreprises utilisent des systèmes de versionnement pour les invites. Comme pour le code, chaque version d’invite est sauvegardée, testée, et comparée. Une invite v2.1 peut être plus efficace que la v2.0. Mais elle peut aussi introduire des biais. Les équipes vérifient donc : la qualité, la diversité, la neutralité. Ce n’est pas un ajustement technique. C’est une décision éthique.

Les fondations : MLOps et culture de l’apprentissage

Cette boucle ne peut pas exister sans MLOps. MLOps, c’est l’ingénierie qui rend l’apprentissage continu possible. C’est la combinaison de l’automatisation, de la surveillance, du contrôle de version, et de la collaboration entre data scientists, ingénieurs et opérateurs.

Une équipe sans MLOps essaie de gérer les modèles à la main. Elle utilise Excel pour suivre les performances. Elle envoie des emails pour déclencher un retraining. Elle oublie les anciennes versions. Elle ne sait pas pourquoi un modèle a échoué. C’est du chaos. Une équipe avec MLOps a des pipelines automatisés. Des tableaux de bord en temps réel. Des alertes. Des journaux complets. Elle sait exactement quand et pourquoi un modèle a changé.

Plus important encore, elle a une culture de l’apprentissage. Les échecs sont documentés. Les réussites sont partagées. Les réunions ne portent pas sur « Qui a cassé le modèle ? », mais sur « Qu’est-ce qu’on a appris ? ». Cette culture transforme l’IA d’un outil technique en un levier stratégique.

Les bénéfices concrets

Quand cette boucle fonctionne, les résultats sont tangibles. Voici ce que les entreprises observent :

- Les erreurs de prédiction diminuent de 40 à 60 % en 6 mois

- Le temps de réponse aux dérives de données passe de 3 semaines à moins de 2 heures

- Les équipes passent 70 % moins de temps à réparer des modèles cassés

- Les utilisateurs fidélisés augmentent, car les systèmes deviennent plus précis et plus pertinents

- Les coûts de maintenance baissent car les pannes sont anticipées, pas réparées

Le coût de ne pas faire cette boucle ? Beaucoup plus élevé. Un modèle qui dérive peut causer des erreurs de diagnostic médical, des décisions financières erronées, des pertes de confiance des clients. Dans certains secteurs, ça peut être légalement risqué.

Comment démarrer ?

Vous n’avez pas besoin de tout réinventer. Commencez petit. Choisissez un modèle critique, pas le plus compliqué. Vérifiez qu’il a un flux de feedback naturel : des utilisateurs qui interagissent, des données qui changent, des métriques que vous suivez déjà.

Ensuite, mettez en place trois choses :

- Un système de collecte de feedback - même manuel au début (un bouton « Signaler une erreur » suffit)

- Un tableau de bord qui affiche les métriques clés en temps réel

- Un pipeline de retraining automatique déclenché par un seuil simple (ex. : précision < 90 % pendant 24h)

Documentez chaque changement. Même les échecs. Dans six mois, vous aurez une bibliothèque de leçons - et votre IA sera bien meilleure qu’avant.

Pourquoi les boucles de feedback sont-elles plus importantes que l’algorithme lui-même ?

Parce que même le meilleur algorithme devient obsolète si les données changent. Un modèle formé sur des données de 2023 ne comprend pas les comportements de 2026. Ce qui compte, ce n’est pas la puissance initiale du modèle, mais sa capacité à s’adapter. La boucle de feedback est ce qui permet cette adaptation. Sans elle, l’IA est comme un pilote qui navigue avec une carte de 1980.

Le retraining automatique est-il risqué ?

Pas s’il est bien encadré. Le risque vient des retrainings non contrôlés. La solution : utiliser des jeux de données de référence (golden datasets), tester les nouveaux modèles avant déploiement, et garder une version précédente en standby. Si le nouveau modèle échoue, vous revenez à l’ancien en 5 minutes. L’automatisation n’est pas une menace - c’est une sécurité si elle est bien conçue.

Quel est le rôle des données dans cette boucle ?

Les données sont la matière première. Un modèle ne peut pas s’améliorer sans données de qualité. Mais ce n’est pas seulement la quantité qui compte - c’est la pertinence. Une donnée mal étiquetée, biaisée, ou hors contexte peut dégrader un modèle plus vite qu’elle ne l’améliore. C’est pourquoi la qualité des données doit être surveillée en continu, pas juste au départ.

Comment savoir si une invite (prompt) est efficace ?

Vous le savez quand elle produit des résultats cohérents, précis, et utiles - et que les utilisateurs n’ont pas besoin de la corriger. L’efficacité se mesure par le taux de rejet : si 80 % des réponses sont utilisées sans modification, l’invite est bien conçue. Si plus de 30 % sont modifiées, il faut la réviser. Les données d’interaction sont votre indicateur le plus fiable.

Est-ce que les petites entreprises peuvent mettre en place ces boucles ?

Oui, et elles devraient. Vous n’avez pas besoin d’une équipe de 20 personnes. Commencez avec un seul modèle, un seul flux de feedback, et un seul pipeline de retraining. Même une solution simple, comme un formulaire Google pour signaler les erreurs + un script Python qui réentraîne la nuit, peut faire une énorme différence. L’important, c’est de commencer - pas de perfectionner.