Les coûts des modèles de langage à grande échelle ne se comportent pas comme ceux d’un logiciel classique

Vous avez peut-être entendu dire que les modèles de langage à grande échelle (LLM) sont « juste une autre technologie ». Si vous les traitez comme ça, vous allez vous retrouver avec une facture cloud de 300 % au-dessus de votre budget. Ce n’est pas une erreur de calcul. C’est une erreur de compréhension. Les LLM ne consomment pas de l’électricité comme un serveur web. Ils consomment des tokens, des GPU, du temps de recherche, et des données propres - tout ça à des rythmes imprévisibles.

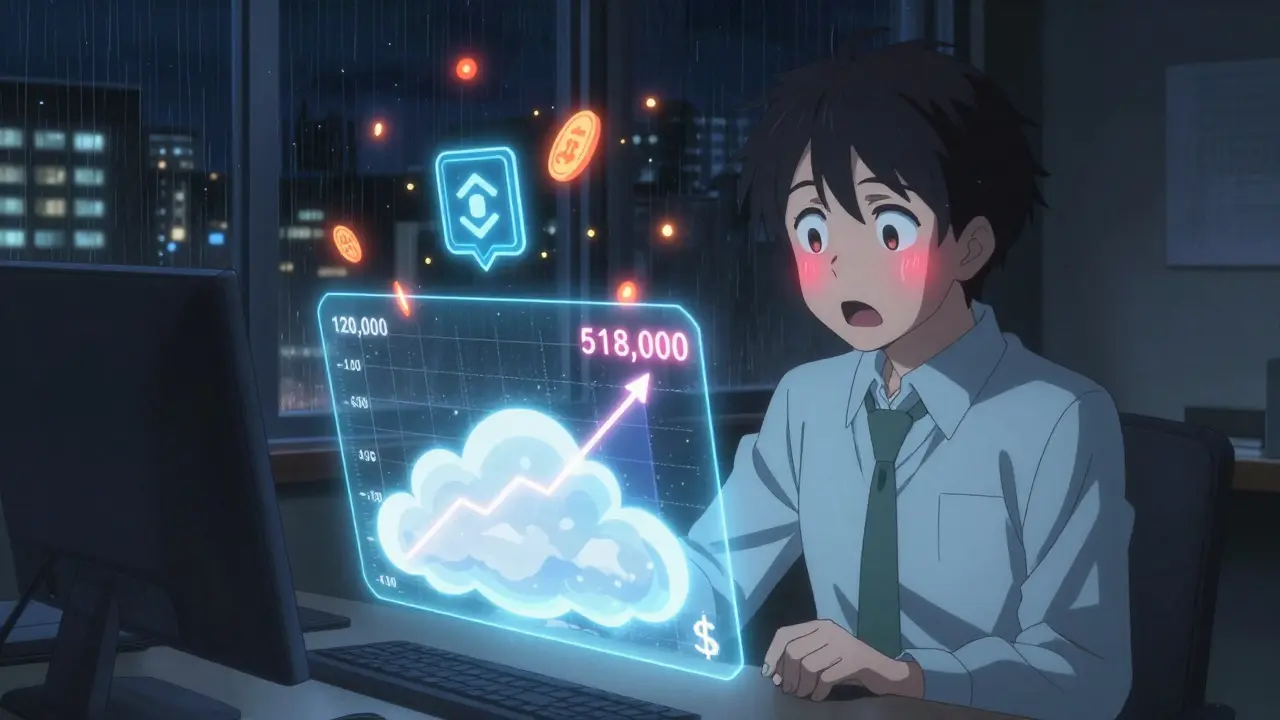

En 2025, une entreprise financière de Charlotte a budgeté 120 000 dollars pour son premier LLM. Six semaines plus tard, la facture s’élevait à 518 000 dollars. Pourquoi ? Parce qu’ils ont oublié que les analystes de la division des ventes utilisaient le modèle à 23h59 chaque dernier jour du mois. Pendant 45 minutes, 217 requêtes simultanées ont déclenché une tempête de tokens. Le modèle n’avait pas été optimisé. Le cache était désactivé. Et personne n’avait prévu ce pic.

Les quatre piliers du budget LLM

Contrairement à un projet logiciel traditionnel, où vous payez pour des serveurs et du développement, les LLM ont quatre coûts principaux qui doivent être budgétisés séparément.

- Entraînement : Pour un modèle de 7 à 13 milliards de paramètres sur AWS p4d.24xlarge, chaque cycle coûte entre 185 000 et 350 000 dollars. Un modèle plus gros, comme GPT-4 ou Llama 3 70B, peut dépasser 2,1 millions de dollars par entraînement. C’est un investissement ponctuel, mais il ne s’arrête pas là.

- Inference : C’est là que la plupart des entreprises se cassent les dents. Le coût par token peut varier de 0,0001 $ à 0,01 $ selon l’optimisation. Vena Solutions a montré que les coûts d’inference non optimisés représentent 40 à 60 % du budget total. Avec une bonne stratégie de cache, de compression et de routage, on peut réduire cela à 15 à 25 %.

- Préparation des données : Dans le secteur financier, la préparation des données - nettoyage, étiquetage, anonymisation, vérification de conformité - consomme entre 22 et 35 % du budget total. Ce n’est pas un « sous-produit ». C’est un pilier.

- Ressources humaines : Vous ne pouvez pas confier la gestion d’un LLM à un comptable qui n’a jamais vu un GPU. Il faut des profils hybrides : des analystes financiers qui comprennent les tokens, des ingénieurs qui savent lire une facture cloud, et des spécialistes FinOps dédiés. 85 % des projets réussis ont un membre dédié à la gestion des coûts IA.

Les erreurs de prévision les plus courantes

Les outils classiques de gestion des coûts cloud - ceux que vous utilisez pour vos applications web - ne fonctionnent pas pour les LLM. Gartner a montré qu’ils ont un taux d’erreur de 47 % sur les prévisions d’IA. Voici les trois erreurs les plus fréquentes.

- Sous-estimer l’inference : 78 % des entreprises pensent que le coût par requête est constant. Il ne l’est pas. Une requête simple peut coûter 0,0002 $, mais une requête complexe avec contexte long et recherche dans des documents peut coûter 100 fois plus. Et si vous avez 500 utilisateurs qui envoient 20 requêtes par jour, ça fait 10 000 requêtes quotidiennes. Multipliez ça par 30 jours. Vous avez un nouveau budget mensuel.

- Ignorer la dérive du modèle : Un modèle qui fonctionne bien en janvier peut se dégrader en mars. Les données changent. Les réglementations évoluent. Les utilisateurs posent de nouvelles questions. Sans surveillance et sans re-entraînement mensuel, les coûts opérationnels augmentent de 30 à 50 % en six mois. Le FinOps Foundation recommande d’allouer 15 à 20 % du budget total à la détection de dérive.

- Ne pas prévoir les pics d’usage : Le cas de l’entreprise de Charlotte n’est pas isolé. Dans les banques, les financements, les assurances, les pics surviennent à la fin du mois, à la fin de l’année, après les rapports trimestriels. Si vous ne modélisez pas ces événements, vous allez être pris au dépourvu. Les outils modernes permettent de créer des scénarios d’usage basés sur les calendriers métier. Ce n’est pas optionnel. C’est obligatoire.

Comment construire un budget réaliste en 5 étapes

Voici une méthode simple, testée sur plus de 120 entreprises en 2025.

- Définissez vos métriques de base : Combien de tokens par requête en moyenne ? (Entre 150 et 500 pour les applications financières). Combien de requêtes par utilisateur par jour ? (Entre 15 et 30 pour les analystes). Combien d’utilisateurs actifs ?

- Calculez l’inference mensuelle : (Tokens par requête) × (Requêtes par utilisateur) × (Utilisateurs) × (Jours ouvrables). Multipliez par le coût par token. Ajoutez 20 % pour les pics.

- Prévoyez l’entraînement et la mise à jour : Combien de fois par mois allez-vous re-entraîner ? Chaque entraînement coûte entre 100 000 et 500 000 dollars selon la taille. Prévoyez 1 à 2 cycles par trimestre pour les modèles financiers.

- Budgetisez la préparation des données : Si vous travaillez dans la finance, prévoyez au moins 25 % du budget total pour nettoyer, structurer et valider les données. C’est un coût récurrent.

- Intégrez une contingence par phase : Selon Sarah Wang de Coherent Solutions, les phases de déploiement ont des besoins différents :

- Expérimental (3-6 mois) : 50 à 70 % de contingence

- Pilote de production (6-12 mois) : 25 à 40 % de contingence

- Déploiement mature (12+ mois) : 10 à 20 % de contingence

Les outils qui fonctionnent - et ceux qui ne servent à rien

En 2025, le marché des outils de gestion des coûts IA a explosé. Mais tous ne sont pas égaux.

| Outil | Précision de prévision | Intégration ERP | Prise en charge des pics d’usage | Coût annuel moyen |

|---|---|---|---|---|

| Cast AI | 89 % | Partielle | Oui | 45 000 $ |

| AWS Cost Explorer (avec IA) | 72 % | Oui | Limitée | 30 000 $ |

| Microsoft Azure Cost Management | 58 % | Oui | Non | 28 000 $ |

| Google Cloud Billing | 51 % | Non | Non | 25 000 $ |

| Outils traditionnels (Jedox, Oracle) | 35 % | Oui | Non | 20 000 $ |

Cast AI est le leader en précision, mais il ne s’intègre pas bien à vos systèmes ERP. AWS a amélioré son outil en décembre 2025 avec une fonctionnalité d’IA dédiée, mais il ne comprend pas encore les scénarios métier complexes. Les outils traditionnels ? Ils sont inadaptés. Vous ne pouvez pas prévoir un pic de 427 % avec un tableau Excel.

La réalité des petites entreprises

Vous êtes une PME ? Vous n’avez pas de budget de 50 000 dollars pour un outil spécialisé. Pas de panique. Vous pouvez quand même faire mieux que la majorité.

- Utilisez les modèles open source comme Mistral 7B ou Llama 3 8B. Ils coûtent 10 fois moins cher à faire tourner.

- Limitez l’accès : créez trois niveaux - basique (recherches simples), standard (avec contexte), premium (avec analyse avancée). Cela réduit les coûts imprévus de 45 % selon Cast AI.

- Utilisez des outils gratuits comme Langfuse ou Weights & Biases pour suivre les tokens et les coûts en temps réel.

- Formez un membre de votre équipe finance à la lecture des factures cloud. Une heure par semaine suffit pour éviter les mauvaises surprises.

Les entreprises de moins de 500 employés ont un taux d’adoption de seulement 28 %. Ce n’est pas parce qu’elles ne peuvent pas. C’est parce qu’elles pensent qu’elles ne peuvent pas. C’est faux.

Le futur : ce qui va changer en 2026

Le CFA Institute prépare des normes de comptabilité pour les coûts IA, qui seront publiées en 2026. Pour la première fois, les dépenses LLM seront classées comme « coûts opérationnels », pas comme « projets expérimentaux ». Cela va forcer les entreprises à les budgétiser comme une facture d’électricité.

La SEC a déjà exigé, en 2025, que les entreprises publiques déclarent leurs coûts d’infrastructure IA dans leurs rapports financiers. Les investisseurs veulent savoir combien vous dépensez pour vos modèles. Pas juste combien vous en gagnez.

En 2027, 75 % des entreprises auront un système de budgetisation LLM dédié. Ceux qui n’en auront pas seront perçus comme risqués. Pas parce qu’ils sont technologiquement en retard. Parce qu’ils sont financièrement irresponsables.

Que faire maintenant ?

Vous ne pouvez pas attendre d’avoir un problème pour commencer. Voici trois actions concrètes à prendre cette semaine :

- Identifiez votre premier LLM en production. Vérifiez sa facture cloud des 30 derniers jours. Notez le coût total. Notez le coût par jour. Notez les pics.

- Calculez combien de tokens vous avez utilisés. Divisez par le nombre d’utilisateurs. Est-ce que chaque utilisateur en consomme 200 ? 500 ? 1 000 ?

- Parlez à votre équipe IT. Demandez-leur : « Si on double le nombre de requêtes demain, combien ça va nous coûter ? » Si la réponse est « Je ne sais pas », vous avez votre premier problème budgétaire.

Les modèles de langage ne sont pas magiques. Ils sont coûteux. Et ils le seront encore plus si vous ne les gérez pas comme un actif financier - pas comme un gadget.

Comment savoir si mon modèle LLM est trop cher ?

Un modèle LLM est trop cher si son coût mensuel dépasse 15 % de votre budget informatique total, ou si son coût par requête est supérieur à 0,001 $ sans optimisation. Mais la vraie question est : « Vaut-il le coup ? » Comparez le coût du modèle au gain en productivité. Si un analyste passe 10 heures par semaine à extraire des données et que le LLM le fait en 20 minutes à 0,0005 $ par requête, alors oui, il est rentable - même s’il coûte 10 000 $ par mois.

Puis-je utiliser un modèle open source pour réduire les coûts ?

Oui, et c’est souvent la meilleure stratégie pour les PME. Les modèles comme Mistral 7B, Llama 3 8B ou Phi-3 coûtent jusqu’à 90 % moins cher à faire tourner que les modèles propriétaires. Leur précision est presque équivalente pour les tâches financières de base. Le seul inconvénient : vous devez gérer vous-même l’infrastructure et la sécurité. Mais avec des outils comme vLLM ou Hugging Face Inference Endpoints, c’est faisable sans équipe d’ingénieurs.

Pourquoi les factures cloud sont-elles si difficiles à comprendre ?

Parce que les fournisseurs de cloud ne veulent pas que vous compreniez. Les prix varient selon la région, le type de GPU, le mode de réservation (spot vs on-demand), et même le moment de la journée. Un A100 peut coûter 1,03 $/heure en Virginie, mais 1,12 $/heure en Californie. Et ils ne vous disent pas que le cache est désactivé par défaut. Vous devez utiliser des outils tiers pour décomposer ces coûts. Sinon, vous payez pour des erreurs que vous ne comprenez pas.

Quel est le rôle du FinOps dans un projet LLM ?

Le FinOps n’est pas un « comptable cloud ». C’est un traducteur entre la finance et la technologie. Il doit savoir ce qu’est un token, comment fonctionne un modèle de langage, et comment lire une facture AWS. Il doit aussi comprendre les cycles métier : quand les analystes travaillent plus, quand les ventes augmentent, quand les rapports sont publiés. Son rôle : transformer les données techniques en prévisions budgétaires claires. Sans lui, vous avez un budget de fiction.

Dois-je budgetiser la formation du personnel ?

Absolument. Les équipes finance n’ont pas été formées pour gérer les LLM. Un analyste qui ne sait pas ce qu’est un token va sous-estimer les coûts de 200 %. La formation FinOps du FinOps Foundation prend 4 à 6 semaines. C’est un investissement. Mais il est moins cher qu’une facture de 500 000 $ inattendue. Mettez-le dans votre budget. Comme un logiciel ou une formation en sécurité.