Vous avez choisi un fournisseur d’IA générative. Vous avez signé le contrat. Le modèle fonctionne. Mais qu’est-ce qui se passe si la qualité des réponses chute de 20 % en deux semaines ? Si le fournisseur utilise vos données pour entraîner un concurrent ? Ou s’il disparaît du marché sans prévenir ? La gestion des fournisseurs pour l’IA générative n’est pas une simple extension de la gestion traditionnelle des logiciels. C’est un nouveau domaine, avec des règles propres, des risques invisibles et des conséquences bien plus graves.

Les SLA ne suffisent plus - il faut des métriques spécifiques à l’IA

Un SLA classique dit : "le système sera disponible 99,9 % du temps". Pour l’IA générative, ça ne veut rien dire. Un système peut être "disponible" tout en produire des réponses fausses, biaisées ou dangereuses. Les SLA doivent être réinventés.

Commencez par trois métriques critiques : le taux d’hallucinations, la dérive du modèle et le temps de réponse sous charge. Un taux d’hallucinations acceptable dépend de l’usage : 2 % pour un assistant juridique, 5 % pour un outil de rédaction interne. Au-delà, vous risquez des erreurs coûteuses. La dérive du modèle est plus subtile : c’est quand un modèle, après une mise à jour, commence à produire des résultats différents sans que vous le sachiez. Un bon SLA exige une détection en temps réel, avec une alerte automatique si la précision chute de plus de 5 % sur 14 jours. Le fournisseur doit aussi garantir un temps de réponse inférieur à 2 secondes pour 95 % des requêtes, même à 100 utilisateurs simultanés.

Et n’oubliez pas la transparence. Le fournisseur doit vous informer par écrit, au moins 30 jours avant toute mise à jour majeure du modèle. Pourquoi ? Parce qu’une mise à jour peut changer complètement le comportement du système - et vous ne voulez pas être surpris lors d’un audit interne ou d’une demande de conformité.

Les audits de sécurité doivent cibler les risques de l’IA, pas seulement les failles informatiques

Un audit de sécurité classique vérifie les pare-feu, les mots de passe et les sauvegardes. Pour l’IA générative, il faut aller plus loin. Posez ces questions concrètes :

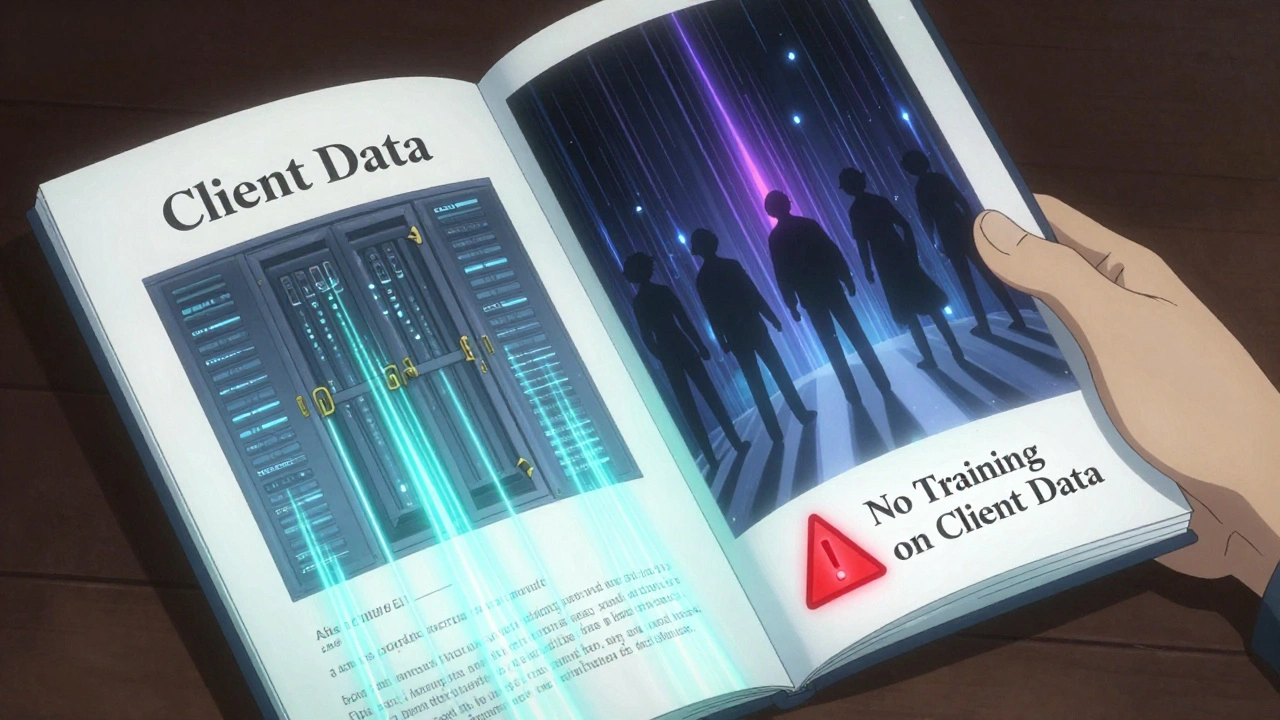

- Les données de mes clients sont-elles utilisées pour entraîner d’autres modèles ? Si oui, comment êtes-vous sûr que ce n’est pas le cas ?

- Comment détectez-vous les attaques par injection de prompts ? Montrez-moi les tests que vous faites chaque mois.

- Quelles mesures prenez-vous pour éviter les biais dans vos données d’entraînement ?

Le cas Amazon en 2018 est un avertissement : un système de recrutement a rejeté les CV de femmes parce qu’il avait été entraîné sur des données historiques où les hommes dominaient les postes techniques. Votre fournisseur doit pouvoir montrer qu’il teste régulièrement ses modèles pour les biais, avec des outils comme Fairlearn ou Aequitas. Il doit aussi garantir que vos données ne sont pas stockées après la fin du contrat - et qu’il vous fournit une preuve écrite de leur suppression.

Les fournisseurs qui refusent de répondre à ces questions ou qui répondent par des formulaires génériques ne sont pas prêts. Les organisations qui ne posent pas ces questions se retrouvent avec des systèmes légalement risqués, voire en violation du RGPD ou de la loi américaine sur l’IA.

Le plan de sortie - la partie qu’aucun fournisseur ne veut discuter

Vous avez signé pour deux ans. Mais que se passe-t-il si le fournisseur fait faillite ? Si vous décidez de changer ? Si un audit révèle qu’il ne respecte plus vos normes ?

La plupart des contrats d’IA générative ne prévoient rien. Et c’est une erreur catastrophique. 68 % des entreprises qui ont perdu un fournisseur d’IA ont subi au moins deux semaines de ralentissement ou de panne complète. Pourquoi ? Parce que les modèles sont souvent verrouillés dans des formats propriétaires. Vous ne pouvez pas les exporter. Vous ne pouvez pas les répliquer. Vous êtes coincé.

Votre contrat doit exiger trois choses :

- La possibilité d’exporter le modèle dans un format ouvert comme ONNX ou TensorFlow SavedModel.

- Un accès complet à vos données d’entraînement, y compris les métadonnées et les logs d’interaction.

- Un support de transition d’au moins 90 jours, avec des sessions de formation pour votre équipe interne.

Et ne vous contentez pas d’un simple document. Exigez un plan d’action écrit, signé par le fournisseur, avec des étapes claires : "Jour 1-15 : export des modèles. Jour 16-45 : transfert des données. Jour 46-90 : accompagnement technique."

Les entreprises qui ont mis en place ce type de plan ont réduit leur temps d’arrêt de 80 %. Ce n’est pas une formalité. C’est une sécurité opérationnelle.

Comment éviter le verrouillage par le fournisseur

Le verrouillage (vendor lock-in) est la règle, pas l’exception. Les fournisseurs veulent que vous dépendiez d’eux. Ils utilisent des API propriétaires, des modèles non standardisés, et des interfaces qui ne parlent qu’à leurs propres outils.

Pour éviter ça, adoptez trois règles simples :

- Ne choisissez jamais un fournisseur qui refuse d’exporter son modèle.

- Privilégiez les fournisseurs qui utilisent des standards ouverts comme Hugging Face, ONNX ou OpenAI’s API compatible avec les modèles open-source.

- Testez dès le début la possibilité de déployer le modèle sur votre propre infrastructure. Si c’est impossible, passez votre chemin.

Les entreprises qui ont commencé avec des modèles open-source comme Llama 3 ou Mistral ont plus de flexibilité. Elles peuvent basculer d’un fournisseur à l’autre sans perdre leurs données ou leur investissement. Ce n’est pas une question de coût - c’est une question de contrôle.

Les outils qui rendent la gestion possible

Vous ne pouvez pas gérer des dizaines de fournisseurs d’IA avec des fichiers Excel et des e-mails. Il vous faut une plateforme dédiée.

Des outils comme LogicGate, RiskRecon ou OneTrust permettent d’automatiser :

- La surveillance continue des SLA (détection automatique des dérives)

- Les audits de sécurité (questionnaires dynamiques adaptés à chaque fournisseur)

- Les alertes de transition (notifications automatiques avant la fin du contrat)

Les équipes qui ont mis en place ces plateformes ont réduit leur temps de gestion des fournisseurs de 60 %. Elles peuvent aussi générer des rapports pour les auditeurs internes ou les régulateurs en un clic.

Vous n’avez pas besoin d’un système complexe au départ. Commencez par un pilote avec un seul fournisseur. Mesurez les gains. Ensuite, étendez.

Les erreurs à ne jamais commettre

Voici les cinq erreurs les plus fréquentes, d’après les retours d’expérience de 30 entreprises :

- Ne pas définir de seuils d’hallucinations acceptables → risque de décisions erronées.

- Ne pas exiger de preuve de suppression des données → violation du RGPD.

- Accepter un fournisseur qui ne permet pas l’export du modèle → verrouillage total.

- Ne pas tester les attaques par prompts → vulnérabilité à l’extraction de données.

- Ne pas impliquer le service juridique dès le début → contrats inapplicables.

La plupart des échecs viennent de l’idée que "l’IA est juste un logiciel de plus". Ce n’est pas vrai. Elle apprend, elle change, elle peut vous tromper sans que vous le sachiez. Vous ne gérez pas un outil - vous gérez un partenaire instable, mais puissant.

Le futur est déjà là - et il exige une nouvelle approche

En 2024, seulement 15 % des entreprises avaient un cadre de gestion des fournisseurs d’IA. En 2026, ce sera 70 %. Ce n’est pas une tendance. C’est une obligation.

Les fournisseurs qui ne proposent pas de SLA adaptés, d’audits de sécurité spécialisés ou de plans de sortie clairs disparaîtront du marché. Ceux qui restent seront ceux qui comprennent que la confiance ne vient pas de la technologie, mais de la transparence, de la préparation et de la responsabilité.

Ne laissez pas votre organisation être la prochaine victime d’un plan de sortie mal préparé. Commencez aujourd’hui. Révisez votre prochain contrat. Posez les bonnes questions. Exigez les bonnes garanties. Parce que dans l’IA générative, la meilleure sécurité, ce n’est pas le chiffrement - c’est la préparation.

Quels sont les trois éléments essentiels d’un SLA pour un fournisseur d’IA générative ?

Un SLA pour l’IA générative doit inclure : (1) des seuils clairs pour le taux d’hallucinations (ex. : max 2-5 % selon l’usage), (2) une détection automatique et en temps réel de la dérive du modèle (ex. : alerte si la précision chute de plus de 5 % sur 14 jours), et (3) une obligation de notification écrite 30 jours avant toute mise à jour majeure du modèle. Ces éléments garantissent la qualité, la stabilité et la transparence du service.

Comment vérifier qu’un fournisseur n’utilise pas mes données pour entraîner ses modèles ?

Demandez une clause contractuelle explicite interdisant l’utilisation de vos données pour l’entraînement de tout autre modèle. Exigez un audit annuel par un tiers indépendant sur la gestion des données. Vérifiez aussi les politiques de confidentialité du fournisseur : s’il ne mentionne pas explicitement la séparation des données clients, c’est un drapeau rouge. Les fournisseurs sérieux utilisent des environnements isolés (data silos) et fournissent des rapports de conformité.

Pourquoi les plans de sortie sont-ils plus critiques pour l’IA que pour les logiciels classiques ?

Parce que les modèles d’IA sont souvent verrouillés dans des formats propriétaires. Contrairement à un logiciel que vous pouvez installer sur votre serveur, un modèle d’IA peut être inaccessible sans l’API du fournisseur. Sans plan de sortie, vous perdez non seulement le service, mais aussi les données, les connaissances et les investissements faits pour l’intégrer. Un bon plan garantit l’export du modèle, la suppression des données et un accompagnement technique pendant 90 jours.

Quels sont les risques les plus sous-estimés dans la gestion des fournisseurs d’IA ?

Le risque le plus sous-estimé est la dérive du modèle. Les entreprises pensent que si le système fonctionne aujourd’hui, il fonctionnera demain. Or, les mises à jour automatiques peuvent altérer les résultats sans avertissement. 62 % des fournisseurs ne proposent pas de mécanisme de détection de dérive dans leur contrat initial. Autre risque : les biais cachés dans les données d’entraînement, qui peuvent entraîner des décisions discriminatoires - comme dans le cas du système de recrutement d’Amazon en 2018.

Faut-il privilégier les fournisseurs open-source pour réduire les risques ?

Oui, mais avec prudence. Les modèles open-source comme Llama 3 ou Mistral offrent plus de transparence et de flexibilité : vous pouvez les déployer sur votre infrastructure, les auditer, et les modifier. Mais cela ne signifie pas qu’ils sont plus sûrs. Le risque se déplace : vous devenez responsable de la sécurité, de la mise à jour et de la maintenance. L’open-source réduit le verrouillage, mais augmente la charge interne. Le bon équilibre est de choisir des fournisseurs qui utilisent des modèles open-source comme base, tout en offrant un support professionnel et des garanties contractuelles.