Vous avez déjà vu une IA générer une réponse qui semble parfaite… mais qui est totalement fausse ? C’est ce qu’on appelle une hallucination. Et dans les entreprises, ça coûte cher. Un client reçoit un email maladroit parce que l’IA a inventé un produit qui n’existe pas. Un agent de service client donne un délai de livraison erroné. Un conseiller financier cite un taux qui n’est plus valide. Ces erreurs ne viennent pas du hasard. Elles viennent du fait que l’IA parle sans regarder les faits.

Qu’est-ce que le grounding en IA ?

Le grounding, c’est l’acte de relier les réponses d’une IA à des sources vérifiables. C’est comme demander à un étudiant de répondre à un examen… en ayant droit à son manuel ouvert. Sans ça, il peut tout inventer. Avec ça, il peut s’appuyer sur ce qui est vrai.

Ce concept vient de la science cognitive, avec le Symbole Grounding Problem de Harnad en 1990. Mais c’est seulement en 2020, avec l’article de Lewis et al. sur la Rétrieval-Augmented Generation (RAG), que cette idée est devenue une technique opérationnelle pour les grands modèles linguistiques. Depuis, les entreprises l’adoptent massivement. Pourquoi ? Parce que les IA non ancrées ont jusqu’à 27 % de chances de mentir. Les IA avec grounding, elles, tombent à 3 %.

Comment ça marche ? Trois étapes simples

Le grounding ne nécessite pas de réentraîner l’IA. Il fonctionne en trois étapes, comme une chaîne de montage :

- Récupération : L’IA cherche dans votre base de données (CRM, manuels internes, documents juridiques) les passages les plus proches de votre question. Elle utilise des vecteurs et une similarité cosinus (généralement entre 0,7 et 0,85) pour trouver ce qui correspond le mieux.

- Enrichissement : Elle prend ces passages (jusqu’à 3 072 tokens dans la plupart des systèmes) et les colle à votre prompt. Votre question devient : « Réponds à ceci, en te basant uniquement sur ces documents. »

- Génération : L’IA produit sa réponse, mais cette fois, elle est contrainte par les faits fournis. Elle ne peut pas sortir de ce cadre.

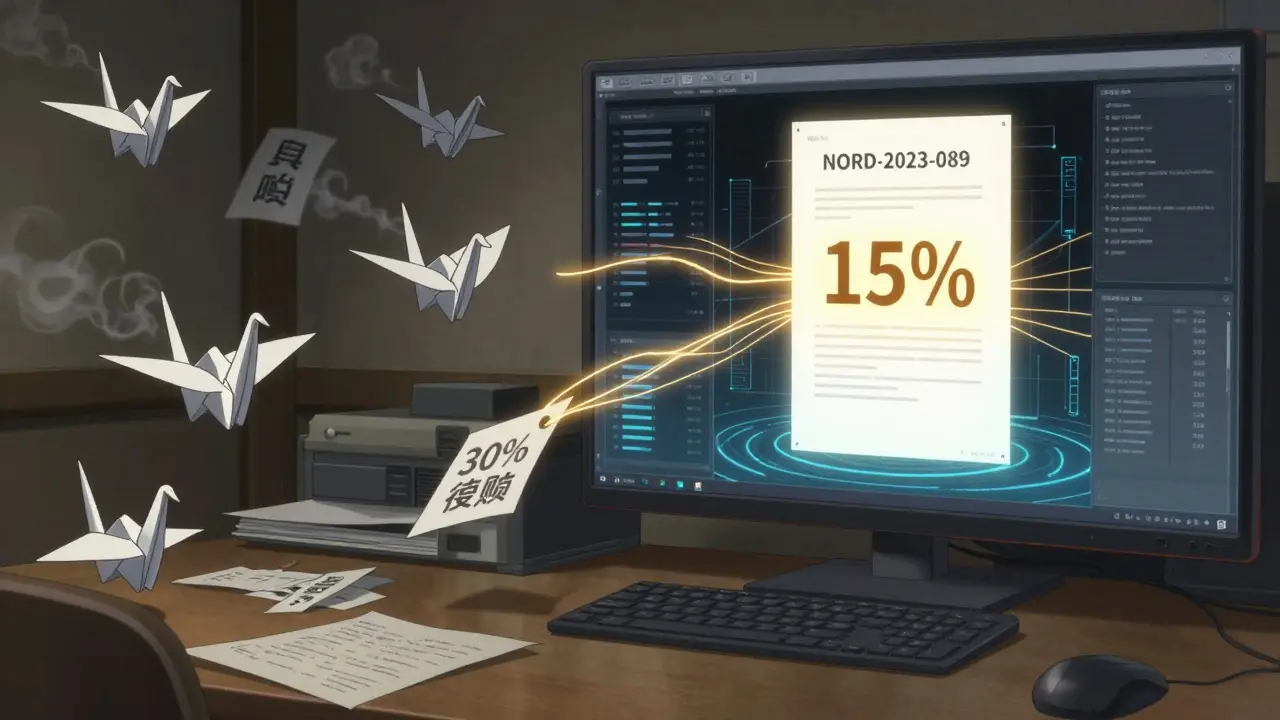

Imaginez que vous demandez : « Quel est le remboursement pour les sneakers Nordstrom ? » Sans grounding, l’IA peut dire « 30 % »… même si votre politique interne dit « 15 % pour les commandes supérieures à 1 000 paires ». Avec grounding, elle lit votre fichier CRM, trouve la commande de 1 200 paires passée l’année dernière, et répond exactement : « 15 %, comme appliqué à la commande #NORD-2023-089. »

Les outils qui font ça aujourd’hui

Vous ne devez pas tout construire vous-même. Plusieurs plateformes proposent déjà le grounding intégré :

- Google Cloud Vertex AI Search : Intègre la récupération dans les chatbots d’entreprise, avec des métriques de précision en temps réel.

- Salesforce Einstein GPT : Relie les réponses directement aux données clients, aux opportunités, aux historiques d’achat. Un utilisateur a rapporté que l’IA génère désormais des emails personnalisés comme : « J’ai vu que vous avez acheté 1 200 paires de sneakers l’année dernière, avec la remise de 15 % sur les commandes en gros. »

- Moveworks : Utilisé dans le support client, il réduit le temps de résolution de 52 % en s’appuyant sur les bases de connaissances internes.

- K2View Grounded AI : Connecte 15+ systèmes (Salesforce, ServiceNow, SharePoint) avec un temps de réponse inférieur à 800 ms pour 95 % des requêtes.

Et ce n’est qu’un début. En janvier 2024, Google a lancé « Grounding Metrics » pour mesurer exactement combien d’hallucinations une IA produit. Salesforce a racheté DataCloud pour améliorer la qualité de ses sources. Meta a open-sourcé RAG 2.0, avec de meilleures recherches multilingues.

Les chiffres qui parlent

Les résultats ne sont pas des promesses. Ils sont mesurés :

- Les réponses inexactes baissent de 63 % dans les entreprises qui utilisent le grounding (Forrester, 2023).

- La pertinence des réponses augmente de 43 % dans les workflows complexes.

- La personnalisation atteint 89 % quand l’IA accède au CRM, contre 62 % sans.

- Les systèmes de recherche traditionnels réussissent à compléter seulement 34 % des tâches. Les IA ancrées, 78 %.

Et les entreprises le savent. En 2022, seulement 12 % des entreprises du Fortune 500 utilisaient le grounding. En 2026, ce sera 89 %. Le marché a bondi de 147 % en un an, pour atteindre 2,3 milliards de dollars en 2023. Il devrait dépasser 14 milliards d’ici 2027.

Les limites réelles - ce que personne ne vous dit

Le grounding n’est pas une baguette magique. Il a des failles.

La première : la taille des contextes. La plupart des modèles ne peuvent traiter que 4 096 tokens. Si votre manuel de 500 pages est chargé en une seule fois, l’IA ne verra que les 10 premières pages. Solution : découper le contenu en petits morceaux (chunking), comme le fait Salesforce avec ses « passages hiérarchiques ».

La deuxième : les homonymes. Si vous demandez « Apple », l’IA ne sait pas si vous parlez de la marque, du fruit, ou de la ville dans l’État de Washington. 37 % des erreurs viennent de ce type d’ambiguïté. Google résout ça avec une recherche hybride (mots-clés + vecteurs). Les autres, pas tant.

La troisième : la sécurité. Votre base de connaissances devient une cible. 22 % des entreprises ont subi une fuite de données pendant la mise en place du grounding. Si vous stockez des contrats, des salaires ou des données clients, il faut du chiffrement de champ à champ - comme chez K2View, qui protège 97 % des éléments sensibles.

Et puis il y a les domaines où ça échoue. En médecine, une étude publiée dans JAMA Internal Medicine montre que 31 % des systèmes d’aide au diagnostic échouent parce que les données médicales ne sont pas dans leur base. L’IA ne peut pas deviner ce qu’elle ne connaît pas.

Comment le mettre en place ?

Vous ne pouvez pas juste dire « je veux du grounding » et attendre que ça marche. Il faut préparer le terrain.

- Nettoyez vos données : 78 % des entreprises doivent d’abord structurer leurs documents internes. Des PDFs mal scannés, des emails désorganisés, des fichiers Excel mal nommés ? Ce n’est pas un problème d’IA. C’est un problème de gestion documentaire.

- Choisissez la bonne base de vecteurs : Pinecone, Weaviate, FAISS. Ce ne sont pas des outils pour les débutants. Vous aurez besoin d’un ingénieur qui sait les configurer.

- Testez avec des cas réels : Ne partez pas sur un projet de 6 mois. Commencez par un seul service : le support client ou la génération d’emails commerciaux. Mesurez la différence avant/après.

- Formez vos équipes : Coursera propose une spécialisation de 42 heures sur le grounding. Ce n’est pas un cours de 10 minutes. C’est une compétence nouvelle, comme apprendre le SQL.

Le temps moyen de déploiement ? 3 à 6 mois. Pour les grandes entreprises, c’est une transformation. Pas une mise à jour logicielle.

Et la réglementation ?

La loi ne va pas tarder à vous forcer à utiliser le grounding.

L’Union européenne vient d’adopter l’AI Act en février 2024. Son article 15 exige expressément des « solutions techniques pour minimiser les risques de génération d’informations fausses ». Le grounding est le seul mécanisme reconnu pour y répondre.

En même temps, le GDPR et le CCPA exigent que les données personnelles soient protégées. Si votre IA accède à des données clients, vous devez pouvoir montrer que vous avez sécurisé l’accès - et que vous n’avez pas stocké les requêtes ou les réponses sans autorisation.

Les entreprises qui n’agissent pas maintenant risquent non seulement des erreurs coûteuses, mais aussi des amendes.

Le futur : plus qu’un prompt, un système

Le grounding ne va pas rester limité aux textes. Les premiers systèmes multimodaux - qui intègrent images, vidéos et documents - montrent une amélioration de 39 % dans les scénarios de support produit. Imaginez : un client envoie une photo d’un produit endommagé. L’IA analyse l’image, la compare aux fiches techniques, et propose un remplacement… tout en citant le numéro de pièce exact.

Et les fournisseurs de grounding indépendants ? Gartner prédit que 75 % seront rachetés par les grands cloud providers (Google, Microsoft, Amazon) d’ici 2026. Ce n’est plus un niche. C’est une fonctionnalité de base.

Le grounding n’est pas une option. C’est la condition pour que l’IA soit fiable. Sans lui, l’IA est un expert qui parle avec confiance… mais qui ne lit jamais les livres.

Si vous utilisez l’IA dans votre entreprise, vous avez deux choix : soit vous laissez l’IA inventer, soit vous lui donnez les faits. Il n’y a pas de milieu.

Quelle est la différence entre le grounding et le fine-tuning ?

Le fine-tuning consiste à réentraîner l’IA sur vos données, ce qui prend des semaines et coûte entre 15 000 et 50 000 dollars. Le grounding, lui, n’altère pas le modèle : il lui donne juste des documents à consulter en temps réel. C’est plus rapide, moins cher, et plus flexible - vous pouvez changer les sources sans réentraîner.

Puis-je utiliser le grounding avec n’importe quel modèle IA ?

Oui, mais seulement si le modèle accepte des prompts enrichis. Les modèles comme GPT-4, Claude 3, ou Llama 3 le permettent. Les modèles propriétaires d’entreprise (comme ceux de Google ou Salesforce) l’intègrent directement. Ce n’est pas une question de modèle, mais d’architecture : vous devez pouvoir injecter du contexte dans la requête avant la génération.

Comment savoir si mon système de grounding fonctionne bien ?

Vérifiez trois choses : 1) Les réponses citent-elles des documents précis ? 2) Les erreurs de fait ont-elles diminué ? 3) Les utilisateurs disent-ils qu’ils ont plus confiance dans les réponses ? Google Cloud propose des métriques de hallucination. Sinon, faites un test manuel : posez 50 questions connues, avec des réponses vérifiables, et comptez combien d’erreurs l’IA fait.

Le grounding protège-t-il ma vie privée ?

Pas automatiquement. Si votre base de connaissances contient des données personnelles, l’IA peut les répéter. Vous devez crypter les champs sensibles (noms, numéros de sécurité sociale, adresses) et limiter l’accès. Les meilleures plateformes comme K2View font cela par défaut. Sinon, vous êtes en violation du GDPR.

Pourquoi les IA sans grounding sont-elles encore utilisées ?

Parce qu’elles sont plus faciles à mettre en œuvre. Vous n’avez pas besoin de bases de données, ni d’ingénieurs en vecteurs. Mais dans les entreprises, le coût des erreurs dépasse largement celui de la mise en place. Ce n’est pas un choix technique - c’est un choix de risque.