Quand vous demandez à une IA de rédiger un e-mail professionnel, elle peut parfois répondre comme un étudiant en première année. Mais si vous lui montrez deux ou trois exemples d’e-mails bien écrits, soudain, elle comprend. Ce n’est pas un miracle. C’est l’apprentissage en few-shot - une méthode simple, puissante, et de plus en plus utilisée pour rendre les IA génératives plus précises, plus cohérentes, et plus utiles.

Qu’est-ce que l’apprentissage en few-shot ?

L’apprentissage en few-shot, c’est quand vous donnez à une IA 2 à 8 exemples d’entrée-sortie avant de lui poser votre vraie question. Pas de réentraînement. Pas de modification du modèle. Juste quelques exemples dans le texte de votre demande. Et pourtant, ça change tout.

Prenons un cas concret : vous voulez que l’IA classifie les retours clients en "positif", "négatif" ou "neutre". En mode zero-shot (sans exemple), elle va deviner en se basant uniquement sur ce qu’elle a appris pendant son entraînement. Résultat ? Parfois juste, souvent approximatif. Maintenant, donnez-lui trois exemples :

- "Le produit est arrivé en avance et fonctionne parfaitement." → positif

- "J’ai attendu trois semaines et le bouton ne marche pas." → négatif

- "C’est un produit comme les autres." → neutre

Ensuite, vous lui posez : "Le service client a été très réactif, mais le packaging était abîmé." Que fait-elle ? Elle répond "neutre" - avec une précision de 85 %, contre 55 % sans exemples. Pourquoi ? Parce que les modèles linguistiques comme GPT-4 ou Claude sont des détecteurs de motifs. Ils ne "comprennent" pas comme nous. Ils reconnaissent des schémas. Et vos exemples leur donnent le modèle à copier.

Zero-shot vs few-shot : quelle différence réelle ?

Le zero-shot, c’est comme demander à quelqu’un de traduire une langue qu’il n’a jamais étudiée. Il va faire de son mieux avec ses connaissances générales. Le few-shot, c’est comme lui donner un dictionnaire bilingue avant de lui demander de traduire. Il va être bien plus précis.

Les études de Touvron et Kaplan (2023) montrent que l’apprentissage en few-shot améliore la précision de 15 à 40 % par rapport au zero-shot. Pourquoi cette différence ? Parce que les modèles ne sont pas des experts. Ils sont des imitateurs. Ils n’ont pas de mémoire interne pour les tâches spécifiques. Mais ils peuvent imiter un style, un format, un ton - si vous leur montrez comment.

Le zero-shot marche bien pour des questions simples : "Quelle est la capitale du Japon ?". Mais dès que vous sortez du général - "Écris un message de remerciement pour un client qui a fait un retour négatif, mais reste poli et professionnel" - vous avez besoin d’un exemple. Un seul peut suffire. Trois, c’est l’optimum.

Comment construire de bons exemples ?

Un mauvais exemple, c’est pire que pas d’exemple. Si vous donnez un exemple trop rare, trop complexe, ou mal structuré, l’IA va l’imiter… et vous donner un résultat bizarre.

Voici les règles simples pour des exemples efficaces :

- Montrez ce que vous voulez, pas ce que vous ne voulez pas. Si vous voulez des réponses courtes, donnez des réponses courtes. Pas des réponses longues suivies de "ne faites pas ça".

- Utilisez des exemples réalistes. Si vous travaillez sur des e-mails professionnels, utilisez des e-mails réels. Pas des modèles de manuel.

- Soignez la structure. Si vous voulez une réponse en liste, montrez une liste. Si vous voulez une réponse en paragraphes, montrez des paragraphes.

- Évitez les exceptions. Un exemple trop particulier (ex : "un client a crié sur le téléphone") peut dérouter l’IA. Restez dans la norme.

- Combinez avec une instruction claire. "Voici trois exemples. Maintenant, classe ce retour client :" est mieux que juste "Voici trois exemples."

Un bon prompt, c’est comme un guide de cuisine avec des photos. Vous ne dites pas "faire un gâteau". Vous montrez un gâteau, vous montrez les étapes, et vous dites "fais comme ça".

Applications concrètes : où ça marche le mieux ?

L’apprentissage en few-shot n’est pas une technique théorique. Il est utilisé tous les jours dans des systèmes réels.

- Chatbots clients : Une banque utilise des exemples de réponses à des questions sur les frais de retrait pour que son chatbot réponde toujours avec le même ton professionnel et précis.

- Génération de code : Un développeur montre à l’IA trois exemples de fonctions Python avec des commentaires, et l’IA génère du code dans le même style - avec les mêmes commentaires, les mêmes noms de variables.

- Analyse de sentiment : Une entreprise analyse les avis sur les réseaux sociaux. Avec des exemples, elle passe de 60 % à 88 % de précision pour détecter les critiques légitimes.

- Documentation technique : Une équipe de développement génère des guides d’utilisation. En donnant à l’IA trois exemples de sections bien écrites, elle produit du contenu uniforme, sans variations de style.

- Rédaction créative : Un éditeur veut des histoires dans le style d’un auteur spécifique. Il donne à l’IA trois extraits de ses textes. L’IA imite le rythme, le vocabulaire, la structure.

Ces exemples ne sont pas des cas isolés. Ce sont des pratiques courantes dans les entreprises qui utilisent l’IA en production. Ce n’est plus de la recherche. C’est du quotidien.

Les limites : ce que few-shot ne fait pas

Malgré son efficacité, few-shot n’est pas une solution magique.

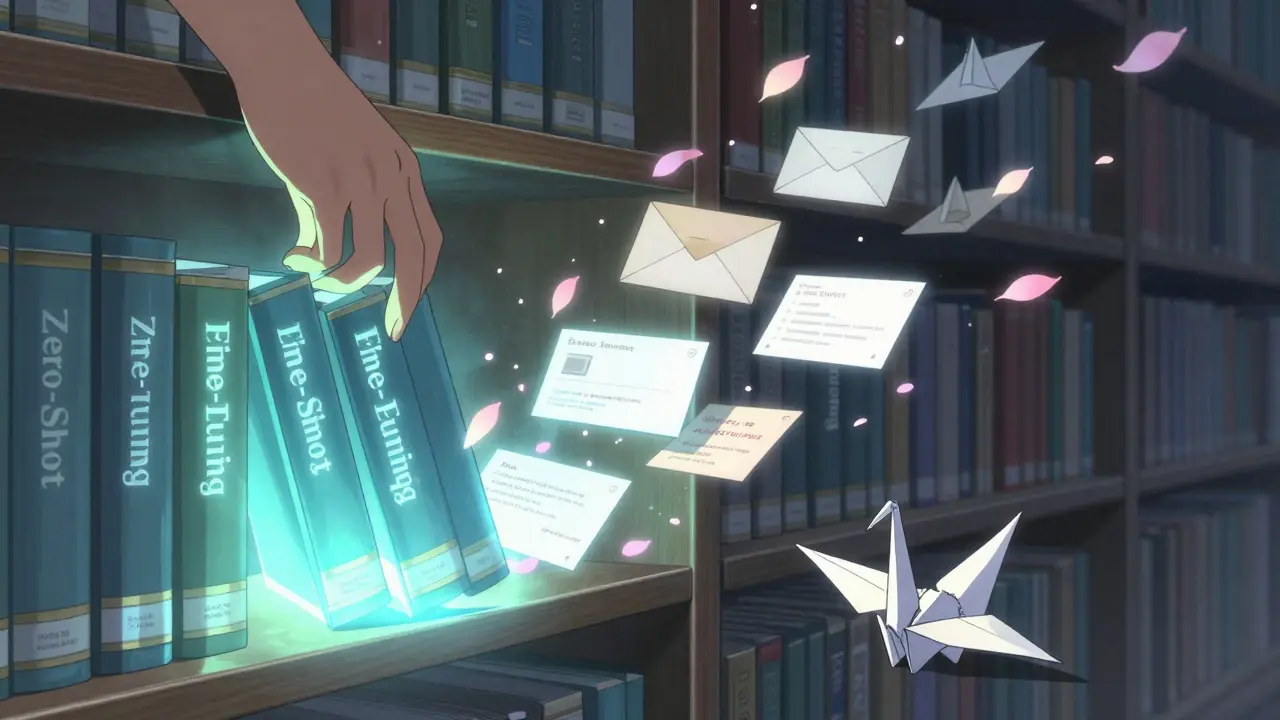

- Il ne remplace pas le fine-tuning. Si vous avez des milliers d’exemples et que vous voulez une performance maximale, réentraîner le modèle (fine-tuning) reste plus efficace. Mais il coûte cher, prend du temps, et demande des compétences techniques. Few-shot, lui, marche en quelques minutes.

- La taille du contexte est limitée. Les modèles ne peuvent pas voir des milliers de lignes. Si vous essayez de mettre 20 exemples, vous risquez de couper la suite de votre demande. L’optimum reste 2 à 8.

- Vous devez les créer vous-même. Il n’y a pas d’outil qui génère automatiquement de bons exemples. Vous devez comprendre votre tâche, et savoir ce que vous voulez comme sortie. C’est du travail humain.

- Chaque requête doit les inclure. L’IA ne se souvient pas des exemples de la dernière fois. Vous devez les répéter à chaque fois. C’est un inconvénient, mais aussi une sécurité : vous contrôlez toujours ce que l’IA voit.

En résumé : few-shot ne résout pas tout. Mais il résout beaucoup de problèmes sans coût, sans complexité, et sans délai.

Le lien avec le fine-tuning : deux chemins, un objectif

Beaucoup pensent que l’IA, c’est soit "zero-shot", soit "fine-tuning". Mais few-shot occupe une place centrale entre les deux.

Le fine-tuning, c’est comme modifier le moteur d’une voiture pour qu’elle roule plus vite. Ça demande du temps, de l’argent, et des compétences techniques. Le few-shot, c’est comme ajuster les commandes du volant et la position du siège. Vous ne changez pas la voiture. Vous changez juste comment vous l’utilisez. Et ça donne des résultats presque aussi bons - avec 1 % du coût.

C’est pourquoi les équipes qui utilisent l’IA en production préfèrent few-shot pour les tâches courantes. Et elles réservent le fine-tuning pour les cas extrêmes : un modèle qui doit comprendre des termes médicaux très spécialisés, ou des lois juridiques d’un pays précis.

Le futur : où va cette technique ?

Les chercheurs combinent déjà few-shot avec d’autres techniques. Par exemple, le "chain-of-thought" : vous demandez à l’IA de montrer son raisonnement étape par étape, en ajoutant des exemples de raisonnements corrects. Ça double la précision sur les problèmes logiques complexes.

Et avec les modèles de plus en plus grands, few-shot devient encore plus puissant. Les modèles d’aujourd’hui reconnaissent des motifs que les modèles de 2022 ne voyaient pas. Ce n’est pas une fonctionnalité ajoutée. C’est une capacité émergente - comme la compréhension du langage, ou la logique. Et comme ces capacités, elle ne va pas disparaître. Elle va s’améliorer.

La prochaine étape ? Des outils qui aident à générer automatiquement des exemples de qualité. Des bibliothèques de prompts testés. Des modèles qui apprennent à choisir les meilleurs exemples pour chaque tâche. Mais le principe restera le même : montrez, ne décrivez pas.

Conclusion : le pouvoir des exemples

Les IA génératives ne pensent pas comme nous. Elles imitent. Et elles imitent mieux quand on leur montre exactement ce qu’on veut.

Plutôt que de passer des heures à écrire des instructions détaillées, utilisez des exemples. Deux. Trois. Pas plus. Et voyez comment la qualité de la réponse change.

C’est la clé : l’apprentissage par l’exemple n’est pas une astuce. C’est la manière naturelle dont ces modèles apprennent. Et c’est la méthode la plus efficace que vous ayez pour les contrôler - sans les réentraîner, sans les coder, sans les payer.

Quelle est la différence entre zero-shot et few-shot ?

Le zero-shot consiste à poser une question à une IA sans lui donner aucun exemple. Elle doit se fier uniquement à ce qu’elle a appris pendant son entraînement. Le few-shot, en revanche, inclut 2 à 8 exemples d’entrée-sortie dans la demande. Ces exemples guident l’IA sur le format, le style ou le raisonnement attendu. Le few-shot est beaucoup plus précis pour les tâches complexes, tandis que le zero-shot convient aux questions générales comme "Quelle est la capitale de l’Allemagne ?"

Combien d’exemples faut-il utiliser pour un bon few-shot ?

Entre 2 et 8 exemples est l’optimum. Moins de deux, et l’IA n’a pas assez de repères. Plus de huit, et vous risquez de dépasser la capacité de contexte du modèle, ce qui peut couper votre demande. Trois exemples sont souvent suffisants pour une amélioration nette de la précision - sans surcharger la requête.

Le few-shot est-il plus cher que le fine-tuning ?

Oui, beaucoup plus cher. Le fine-tuning nécessite de réentraîner le modèle avec des données spécifiques, ce qui demande du temps, de la puissance de calcul, et souvent une équipe technique. Le few-shot ne coûte rien en ressources : vous n’avez qu’à ajouter quelques exemples à votre texte. C’est gratuit, rapide, et immédiat.

Le few-shot fonctionne-t-il avec tous les modèles d’IA ?

Oui, mais seulement avec les modèles de grande taille (comme GPT-4, Claude 3, Llama 3). Les petits modèles n’ont pas la capacité de reconnaître les motifs à partir de quelques exemples. Le few-shot est une capacité émergente : elle apparaît seulement quand le modèle est suffisamment grand. Si votre IA ne le fait pas, ce n’est pas un bug - c’est une limitation de taille.

Peut-on combiner few-shot avec d’autres techniques de prompt ?

Absolument. La combinaison la plus puissante est few-shot + chain-of-thought : vous donnez des exemples d’entrée-sortie, mais aussi des exemples où l’IA explique son raisonnement étape par étape. Cela améliore considérablement la précision sur les tâches logiques, mathématiques ou de décision complexe. C’est devenu une pratique standard dans les équipes qui veulent la meilleure qualité possible.

Si vous utilisez une IA pour produire du contenu, du code ou des réponses clients, arrêtez de décrire ce que vous voulez. Montrez-le. C’est la seule manière de faire en sorte qu’elle le fasse bien.