Vous avez entendu parler du coding vibre - ce nouveau mode de développement où les développeurs discutent avec une IA pour générer du code, comme si elle était leur partenaire de pair programming. Mais si vous passez à cette méthode, comment savez-vous si ça marche vraiment ? Vous ne pouvez pas juste mesurer les lignes de code par heure. Les anciens KPI ne fonctionnent plus. Vous avez besoin de nouvelles métriques, précises, qui reflètent ce qui se passe vraiment quand un humain et une machine écrivent du logiciel ensemble.

La durée de cycle : votre indicateur le plus immédiat

La durée de cycle - le temps entre le moment où vous commencez un ticket et celui où il est en production - est le premier KPI à surveiller. Dans les équipes traditionnelles, créer un composant d’interface prend en moyenne 6,6 heures. Avec le coding vibre, ce temps tombe à 3,2 heures. C’est une accélération de 51 %. Pour les tâches répétitives comme configurer une API ou générer du boilerplate, les gains peuvent atteindre 81 %. C’est énorme pour les startups ou les petites équipes qui doivent livrer vite.

Mais attention : cette accélération ne s’applique pas à tout. Pour le code de sécurité ou les algorithmes complexes, l’IA n’apporte qu’un gain de 12 %. Pourquoi ? Parce que les développeurs doivent vérifier, relire, réécrire. Le vrai indicateur ici, ce n’est pas juste le temps total, c’est le temps de validation. Si vous passez 4 heures à générer du code et 3 heures à le corriger, vous n’avez pas gagné. La bonne pratique ? Mesurez la durée de cycle avec les étapes de vérification incluses. Les équipes qui intègrent des tests automatisés dès la génération voient leurs défauts en production baisser de 29 %, même si leur pipeline devient un peu plus lent au départ.

Les taux de défauts : le piège de la vitesse

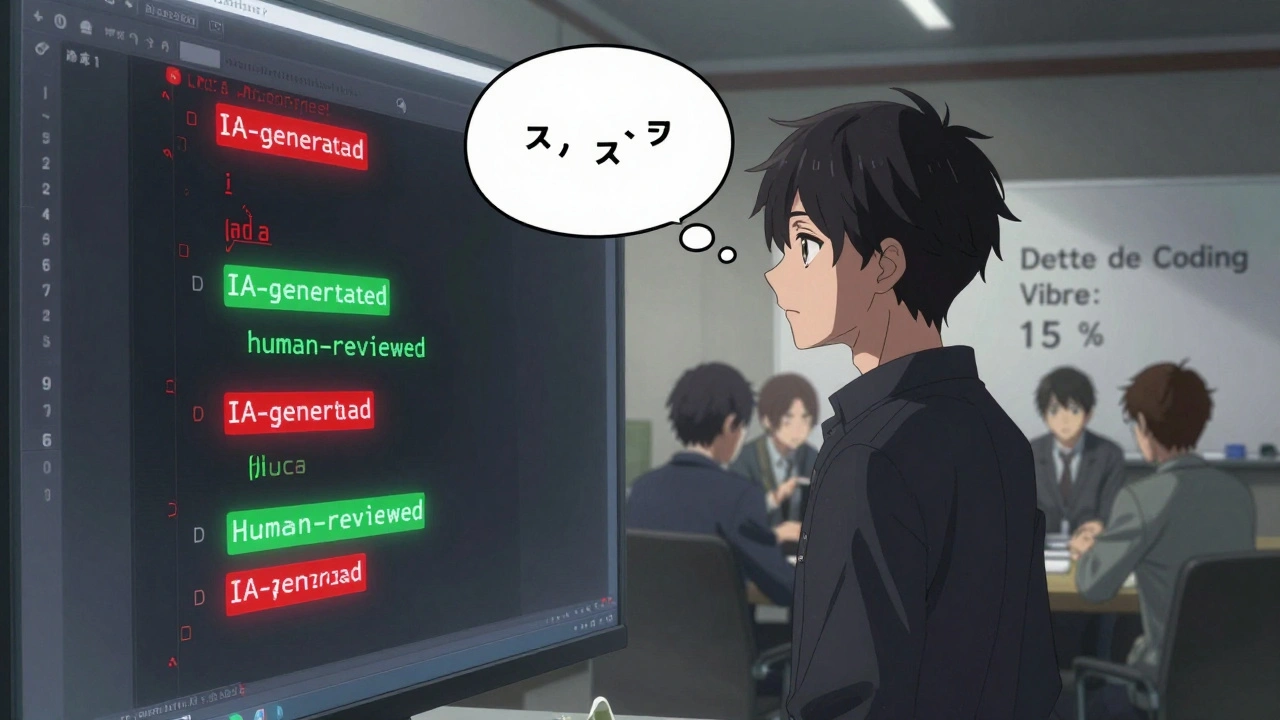

Les premiers résultats sont séduisants : du code qui sort vite. Mais ce qui vous attend derrière, c’est la dette technique. Une étude d’Arsturn en 2025 montre que les équipes débutantes en coding vibre ont 18 % de défauts en plus en production. Pourquoi ? Parce que l’IA génère du code qui semble fonctionner… mais qui est fragile. Un endpoint qui marche pour 99 % des cas, mais qui plante quand un utilisateur entre un caractère spécial. Une fonction qui utilise une bibliothèque obsolète. Un authentification qui semble correcte… mais contient une faille critique.

Les équipes qui réussissent ne cherchent pas à éliminer les défauts. Elles mesurent la dette de coding vibre. C’est le pourcentage de code généré par l’IA qui doit être réécrit ou refactorisé après 90 jours. Dans les mauvaises implémentations, ce chiffre atteint 38 %. Dans les meilleures, il est sous 15 %. Comment le suivre ? Ajoutez un tag dans votre système de suivi : « généré par IA ». Ensuite, chaque fois que vous corrigez un bug ou que vous améliorez une fonction, notez si c’est du code issu de l’IA. Après 6 mois, vous aurez une image claire : votre IA vous aide ou vous encombre ?

La charge cognitive : le KPI invisible

Le vrai secret du coding vibre, c’est la conversation. Pas le code. Ce n’est pas une machine qui écrit pour vous - c’est un partenaire avec qui vous négociez. Chaque fois que vous devez reformuler votre prompt, que vous devez revenir en arrière, que vous devez expliquer à nouveau ce que vous voulez… vous perdez de l’énergie. C’est ce qu’on appelle la charge cognitive.

Un développeur expérimenté sur Reddit a noté : « Si ça prend plus de 3 itérations pour obtenir du code fonctionnel, je le réécris moi-même. » C’est une règle simple, mais puissante. Pourquoi ? Parce que chaque itération supplémentaire est un signe que l’IA ne comprend pas votre contexte. Et si l’IA ne comprend pas, vous non plus. Et si vous ne comprenez pas le code que vous déployez, vous ne pouvez pas le maintenir.

Les meilleures équipes mesurent le nombre moyen d’itérations par tâche. Elles visent moins de 2,5. Elles utilisent aussi des outils qui analysent les prompts : si vous utilisez souvent des mots comme « probablement », « je pense que », ou « un peu comme »… c’est un signe que vous n’êtes pas clair. Et si vous ne l’êtes pas, l’IA ne peut pas vous aider.

La dépendance à l’IA : votre ratio critique

Une équipe de 12 développeurs a publié sur GitHub en 2025 qu’elle suivait un indicateur simple : le ratio de dépendance à l’IA. Combien de code est-il généré directement par l’IA, sans modification ? Combien est-il écrit par vous, après avoir lu et compris ce que l’IA a proposé ?

Les équipes performantes maintiennent ce ratio entre 30 % et 50 %. Moins de 30 % ? Vous utilisez l’IA comme un correcteur orthographique. Vous perdez le potentiel. Plus de 50 % ? Vous êtes en train de vous désapprendre à coder. Vous ne comprenez plus ce que vous déployez. Et un jour, un bug critique apparaît. Vous ne savez pas pourquoi. Vous ne pouvez pas le réparer. Et vous perdez du temps à chercher qui a écrit ce code… alors que c’est une machine.

Le bon équilibre ? L’IA fait le répétitif. Vous faites le complexe. L’IA génère le formulaire d’inscription. Vous écrivez la logique de validation des données sensibles. L’IA crée les tests unitaires. Vous décidez quels cas limites sont critiques. C’est une collaboration, pas une déléguer.

La sécurité : où l’IA vous piège

Le coding vibre est un excellent outil… sauf quand il s’agit de sécurité. Une analyse de Snyk en 2025 a montré que le code généré par l’IA contient 27 % de vulnérabilités en plus que le code écrit manuellement. Pourquoi ? Parce que l’IA apprend sur des données publiques. Elle a vu des exemples de code avec des failles de type SQL injection, XSS, ou authentification faible. Elle les reproduit, parce qu’ils sont « courants ». Elle ne sait pas que ces exemples sont dangereux.

Les équipes qui ne mesurent pas la sécurité en coding vibre se font piéger. Un développeur sur Stack Overflow a raconté : « On n’a mesuré que la vitesse. On a déployé 41 % de code d’authentification généré par IA. Il n’y avait aucun test. Le pentest a révélé 3 failles critiques. »

La solution ? Ajoutez des règles de linting spécifiques pour le code IA. Utilisez des outils comme Snyk ou SonarQube pour scanner automatiquement chaque fichier généré. Exigez que chaque fonction d’authentification, de paiement ou d’accès aux données sensibles soit vérifiée manuellement - même si l’IA l’a écrit. Et mesurez le taux de vulnérabilités dans le code généré par IA. Si ce taux dépasse 5 %, vous avez un problème de processus, pas de technologie.

La compréhension du code : le KPI le plus important

Le plus grand risque du coding vibre, ce n’est pas la lenteur. Ce n’est pas les défauts. C’est la perte de compétence. Quand un développeur junior déploye du code qu’il ne comprend pas, il devient un simple exécutant. Il ne devient plus un ingénieur. Il devient un opérateur d’IA.

Dr. Marcus Chen, expert en cybersécurité, l’a dit clairement : « Le KPI le plus manquant, c’est le taux de compréhension du code généré par l’IA. » Et il a raison. Si vous ne comprenez pas ce que vous déployez, vous ne pouvez pas le maintenir. Vous ne pouvez pas le faire évoluer. Et si l’IA change de version, ou si vous devez migrer vers un autre outil, vous êtes bloqué.

Comment mesurer ça ? Introduisez des « vérifications de compréhension ». Après qu’un développeur a utilisé l’IA pour générer un morceau de code, demandez-lui : « Explique-moi pourquoi ce code fait ça. » « Qu’est-ce qui se passe si l’entrée est nulle ? » « Quelle est la limite de cette fonction ? »

Si la réponse est vague, ou si la personne dit « je ne sais pas, c’est l’IA qui l’a écrit »… c’est un signal d’alarme. Vous avez un problème de formation, pas de productivité. Les équipes qui réussissent font des revues de code avec des questions de compréhension. Elles ne valident pas le code tant que le développeur ne peut pas l’expliquer.

Comment commencer ? Votre checklist simple

Vous ne pouvez pas tout mesurer en même temps. Commencez par ces 5 KPI :

- Durée de cycle : mesurez le temps total, incluant vérification et tests.

- Taux de défauts en production : comparez avec votre historique avant le coding vibre.

- Ratio de dépendance à l’IA : quel pourcentage de code est généré sans modification ?

- Nombre d’itérations par tâche : combien de fois devez-vous reformuler votre prompt ?

- Taux de compréhension : pouvez-vous expliquer le code généré par l’IA ?

Intégrez-les dans votre tableau de bord quotidien. Ne les ignorez pas. Ne les laissez pas aux managers. Chaque développeur doit les voir, les comprendre, les améliorer.

Le futur : des KPI qui prédisent

Les équipes les plus avancées ne mesurent plus seulement ce qui s’est passé. Elles prédisent ce qui va arriver. Des outils comme SideTool Vibe Analytics utilisent l’IA pour analyser vos prompts et prédire quelles parties du code vont générer des défauts. Si vous utilisez souvent le mot « rapide » dans vos prompts, l’outil vous avertit : « Attention, ce type de demande génère 62 % de code fragile. »

Dans 3 ans, tous les bons développeurs sauront : ce n’est pas la vitesse qui compte. C’est la qualité durable. Ce n’est pas la quantité de code généré. C’est la profondeur de compréhension. Ce n’est pas l’IA qui fait le travail. C’est vous - avec l’IA comme outil, pas comme remplacement.

Le coding vibre n’est pas une révolution. C’est une évolution. Et comme toute évolution, elle demande de nouveaux repères. Mesurez bien. Apprenez. Et surtout, ne laissez pas la machine écrire pour vous. Écrivez avec elle.

Quels sont les 5 KPI essentiels pour mesurer le succès du coding vibre ?

Les cinq KPI les plus importants sont : la durée de cycle (temps de développement + vérification), le taux de défauts en production, le ratio de dépendance à l’IA (pourcentage de code généré sans modification), le nombre d’itérations nécessaires pour obtenir un code fonctionnel, et le taux de compréhension du code généré (mesuré par des explications orales ou écrites). Ces indicateurs combinés donnent une image complète de la productivité, de la qualité et de la durabilité du processus.

Pourquoi les anciens KPI comme les lignes de code par heure ne fonctionnent-ils plus ?

Les lignes de code par heure encouragent la production rapide, pas la qualité. Avec le coding vibre, l’IA peut générer des centaines de lignes en quelques secondes - mais ces lignes peuvent être inutiles, inutilement complexes, ou même dangereuses. Un bon développeur ne produit pas du code. Il produit du logiciel fiable. Mesurer la quantité, c’est comme juger un chef cuisinier au nombre de cuillères qu’il utilise, pas à la qualité du plat.

Qu’est-ce que la dette de coding vibre et comment la mesurer ?

La dette de coding vibre est le pourcentage de code généré par l’IA qui doit être réécrit ou refactorisé après 90 jours. Elle se mesure en taguant chaque fichier généré par IA, puis en suivant combien de ces fichiers doivent être modifiés dans les mois suivants. Une équipe avec une dette supérieure à 30 % a un problème de contrôle qualité ou de formation. Le but est de maintenir cette dette sous 15 %.

Le coding vibre rend-il les développeurs moins compétents ?

Oui, si on l’utilise mal. Si les développeurs dépendent de l’IA pour tout, sans comprendre ce qu’elle génère, ils perdent leurs compétences fondamentales. Les équipes qui réussissent utilisent l’IA pour automatiser les tâches répétitives, mais exigent que chaque développeur comprenne et puisse expliquer chaque morceau de code qu’il déploye. C’est la compréhension, pas la génération, qui fait un bon ingénieur.

Faut-il interdire l’IA pour le code de sécurité ?

Non, mais il faut la contrôler. L’IA peut générer des vulnérabilités 27 % plus fréquentes dans le code de sécurité. La solution n’est pas de l’interdire, mais d’ajouter des vérifications obligatoires : tests automatisés spécifiques, revues manuelles, linting adapté. Toute fonction d’authentification, de paiement ou d’accès aux données sensibles doit être vérifiée par un humain - même si l’IA l’a écrite. La sécurité ne se déléguera jamais à une machine.