Les modèles de langage comme GPT-4 ou Claude 3.5 ne se contentent plus de répondre. Ils commencent à réfléchir à la façon dont ils réfléchissent. Ce n’est pas un effet de bord. C’est une avancée majeure appelée meta-raisonnement. Et elle change tout.

Imaginez un assistant qui, avant de répondre à une question complexe, se demande : "Est-ce que je devrais utiliser une approche linéaire, ou plutôt explorer plusieurs pistes en parallèle ?" Il évalue ses propres stratégies, choisit la meilleure, puis agit. Ce n’est plus de la programmation. C’est de la métacognition - la capacité à penser à sa propre pensée. Et c’est exactement ce que le meta-raisonnement permet aux LLM de faire.

Comment ça marche ? Le processus en deux étapes

Le système le plus avancé aujourd’hui s’appelle Meta-Reasoning Prompting (MRP). Il a été présenté en juin 2024 par une équipe de chercheurs dans un papier scientifique qui a fait le tour du monde de l’IA. MRP repose sur deux phases simples, mais puissantes.

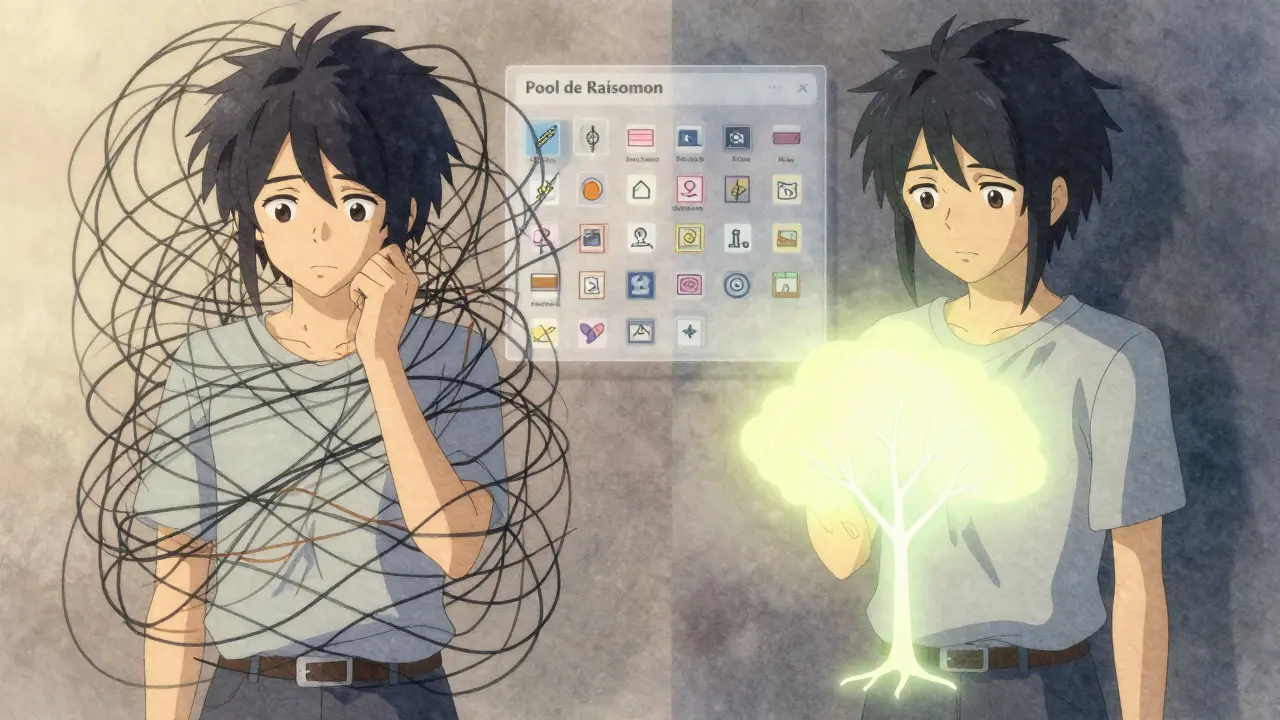

La première phase, c’est la sélection de la méthode de raisonnement. L’LLM reçoit une question - par exemple, "Quel est l’impact d’une hausse des taux d’intérêt sur les ventes de voitures électriques ?" Au lieu de plonger directement dans la réponse, il consulte une liste prédéfinie de méthodes appelée "Pool de raisonnement". Cette liste contient des descriptions claires de techniques comme Chain-of-Thought, Tree-of-Thoughts, ou Step-Back. Il analyse la question, compare les méthodes disponibles, et choisit celle qui semble la plus adaptée.

La deuxième phase, c’est l’exécution. Une fois la méthode choisie, l’LLM l’applique avec précision. Pas de mélange. Pas de confusion. Il suit la stratégie sélectionnée jusqu’au bout.

Le résultat ? Une précision plus élevée et moins de ressources gaspillées. Sur le benchmark GSM8K (des problèmes mathématiques complexes), MRP atteint 78,3 % de précision. C’est 4,2 points de plus que le Chain-of-Thought classique. Et il utilise 17 % moins de puissance de calcul. Pourquoi ? Parce qu’il n’applique pas toujours la méthode la plus lourde. Il la choisit.

Le vrai pouvoir : adapter la stratégie à la tâche

Les anciennes méthodes forçaient les modèles à utiliser la même approche, peu importe le problème. Chain-of-Thought ? Toujours. Tree-of-Thoughts ? Toujours. Mais ce n’est pas intelligent. Certains problèmes nécessitent une logique linéaire. D’autres, une exploration en arborescence. D’autres encore, une remise en question des hypothèses de départ.

MRP excelle là où les autres échouent. Par exemple, Tree-of-Thoughts donne de très bons résultats sur les tâches de planification (82,1 % de précision), mais tombe à 67,3 % sur les problèmes mathématiques. MRP, lui, reste stable entre 76,8 % et 81,4 % sur toutes les tâches. Pourquoi ? Parce qu’il ne tente pas d’être bon à tout. Il cherche à être approprié à chaque cas.

Cette flexibilité a un impact concret. Une entreprise financière a réduit de 29 % le temps de prise de décision sur les risques de prêt en utilisant MRP. Les analystes ont rapporté une confiance de 41 % plus élevée dans les recommandations de l’IA. Ce n’est pas un hasard. C’est la conséquence directe d’un système qui s’adapte.

Le rôle des méthodes dans le "Pool de raisonnement"

Le secret de MRP, c’est la qualité du Pool de raisonnement. Ce n’est pas une simple liste. C’est un ensemble de descriptions précises, objectives, et testées. Chaque méthode doit être définie comme : "Quand utiliser cette méthode ? Quels sont ses avantages ? Quels sont ses échecs courants ?"

Si les descriptions sont floues, le système échoue. Les chercheurs ont fait une expérience : ils ont délibérément rendu les descriptions imprécises. Résultat ? La précision a chuté de 12,7 points. C’est une leçon cruciale : le meta-raisonnement ne fonctionne pas avec des prompts vagues. Il exige de la rigueur.

Les méthodes courantes dans le Pool incluent :

- Chain-of-Thought : décompose la question en étapes logiques, une à une. Idéal pour les problèmes mathématiques ou les raisonnements linéaires.

- Tree-of-Thoughts : explore plusieurs chemins en parallèle comme un arbre. Très utile pour les décisions complexes avec plusieurs scénarios.

- Step-Back Prompting : demande au modèle de revenir à une notion plus générale avant de répondre. Puissant pour les questions ambiguës ou les biais cachés.

- Self-Ask : génère des questions internes pour clarifier l’objectif. Utile pour les tâches de compréhension de texte.

La taille idéale du Pool ? Entre 4 et 7 méthodes. Plus que ça, et le modèle se perd. Moins, et il manque de flexibilité. Les développeurs expérimentés recommandent de commencer avec 3 méthodes seulement, et d’ajouter progressivement.

Qui en profite ? Les secteurs en première ligne

Le meta-raisonnement n’est pas une curiosité technique. Il est déjà utilisé dans des domaines où les erreurs coûtent cher.

- Services financiers (28 % des utilisateurs) : analyse des risques, prévisions de marché, détection de fraude. MRP réduit les faux positifs et améliore la traçabilité des décisions.

- Santé (22 %) : aide au diagnostic différentiel, interprétation de rapports médicaux. Le modèle peut choisir entre une approche basée sur les preuves cliniques ou une analyse des symptômes contextuels.

- Tech juridique (19 %) : analyse de contrats, recherche de jurisprudence. Ici, la capacité à alterner entre raisonnement logique et interprétation de contexte est essentielle.

Les entreprises de ces secteurs ont compris une chose : une IA qui réfléchit à sa propre méthode est plus fiable, plus transparente, et moins coûteuse à maintenir. Selon une étude de MetaIT, MRP réduit les coûts d’implémentation de 22 % en évitant les surdimensionnements inutiles.

Limites et défis réels

Malgré ses avantages, MRP n’est pas parfait.

La première limite : la dépendance au modèle. GPT-4 atteint 84,6 % de précision sur les benchmarks de raisonnement. GPT-3.5, lui, n’atteint que 76,1 %. Plus le modèle est grand, mieux il évalue ses propres méthodes. Les modèles plus petits, comme Llama 3 ou Mistral, peinent encore à faire ce saut métacognitif.

La deuxième limite : l’ambiguïté. Quand une question peut être traitée par plusieurs méthodes à peu près aussi bien, le système hésite. Sur GitHub, 9 des 27 problèmes signalés concernent des sélections incohérentes sur des tâches floues. La version 1.2 de MRP, sortie en janvier 2025, tente de corriger ça avec un "score de confiance" pour chaque méthode. C’est un début.

La troisième limite : la complexité de mise en œuvre. Un développeur a rapporté sur Reddit avoir passé 40 heures à créer le Pool pour une application médicale. C’est un travail d’expert. Il faut connaître les méthodes, leurs limites, et les domaines d’application. Ce n’est pas un "plug-and-play".

Le futur : vers une IA qui apprend à raisonner

Le meta-raisonnement n’est qu’un premier pas. Les chercheurs travaillent déjà sur la prochaine étape : intégrer cette capacité directement dans l’entraînement du modèle. Pas juste en prompt, mais dans les poids du réseau.

OpenAI teste des architectures inspirées de MRP dans son GPT-5. Anthropic a déjà intégré des principes similaires dans Claude 3.5. Le but ? Créer des modèles qui ne se contentent pas d’adapter leur méthode à chaque question… mais qui apprennent à choisir mieux avec l’expérience.

À long terme, on pourrait voir des IA capables de créer leurs propres méthodes de raisonnement - pas seulement de les sélectionner. Cela ouvrirait la porte à une nouvelle forme d’intelligence artificielle : non plus une machine qui suit des règles, mais une entité qui les conçoit.

En 2026, Gartner prévoit que 75 % des déploiements d’IA en entreprise intégreront une forme de meta-raisonnement. Ce n’est pas une hypothèse. C’est une trajectoire. Et les premiers utilisateurs le savent déjà : l’IA la plus puissante n’est pas celle qui répond le plus vite. C’est celle qui sait quand ne pas répondre - et comment le faire mieux la prochaine fois.

Qu’est-ce que le meta-raisonnement dans les LLM ?

Le meta-raisonnement est la capacité d’un modèle de langage à évaluer et à choisir dynamiquement sa propre méthode de raisonnement avant de répondre à une question. Plutôt que d’utiliser toujours la même stratégie (comme Chain-of-Thought), il consulte une liste de méthodes disponibles, analyse la tâche, et sélectionne celle qui semble la plus adaptée - comme un humain qui réfléchit à la meilleure façon de résoudre un problème.

Quelle est la différence entre meta-raisonnement et Chain-of-Thought ?

Chain-of-Thought est une méthode fixe : elle oblige le modèle à décomposer la réponse en étapes logiques, peu importe la question. Le meta-raisonnement, lui, est flexible. Il peut choisir Chain-of-Thought, Tree-of-Thoughts, Step-Back, ou une autre méthode, selon la nature du problème. C’est comme passer d’un marteau unique à une boîte à outils intelligente.

Le meta-raisonnement fonctionne-t-il sur les petits modèles comme Llama 3 ?

Pas aussi efficacement. Les modèles plus petits, comme Llama 3 ou Mistral, manquent de la capacité à évaluer précisément les différentes méthodes de raisonnement. Les résultats sont moins stables. Le meta-raisonnement fonctionne le mieux sur les grands modèles comme GPT-4 ou Claude 3.5, qui ont plus de paramètres pour comprendre les nuances des méthodes. Les chercheurs travaillent à rendre cette capacité plus accessible, mais ce n’est pas encore une réalité pour les modèles légers.

Quels sont les risques d’utiliser le meta-raisonnement ?

Le principal risque est une mauvaise conception du "Pool de raisonnement". Si les descriptions des méthodes sont vagues ou incorrectes, le modèle choisira mal - et produira des réponses erronées avec plus de confiance. Il y a aussi un risque de surcomplexité : trop de méthodes dans le Pool peuvent paralyser le modèle. Enfin, il n’existe pas encore de standard pour vérifier la transparence du choix effectué, ce qui pose des questions pour les applications à haut risque comme la santé ou la justice.

Est-ce que le meta-raisonnement réduit vraiment les coûts d’IA ?

Oui, dans certains cas. En choisissant la méthode la plus efficace pour chaque tâche, le modèle utilise moins de puissance de calcul. Une entreprise a réduit ses coûts de traitement de 17 % en passant à MRP. Selon des analystes, l’adoption généralisée pourrait réduire les coûts d’implémentation de 22 % en évitant les surdimensionnements. Ce n’est pas une économie massive sur chaque requête, mais sur des millions de requêtes, ça compte.

Où puis-je trouver des exemples pratiques de MRP ?

Le dépôt GitHub "meta-reasoning/mrp-examples" (142 étoiles au 15 janvier 2025) contient 12 exemples concrets pour différents domaines : finance, santé, juridique, etc. Il propose des templates pour créer votre propre Pool de raisonnement, avec des descriptions de méthodes prêtes à l’emploi. C’est le meilleur point de départ pour les développeurs qui veulent expérimenter.