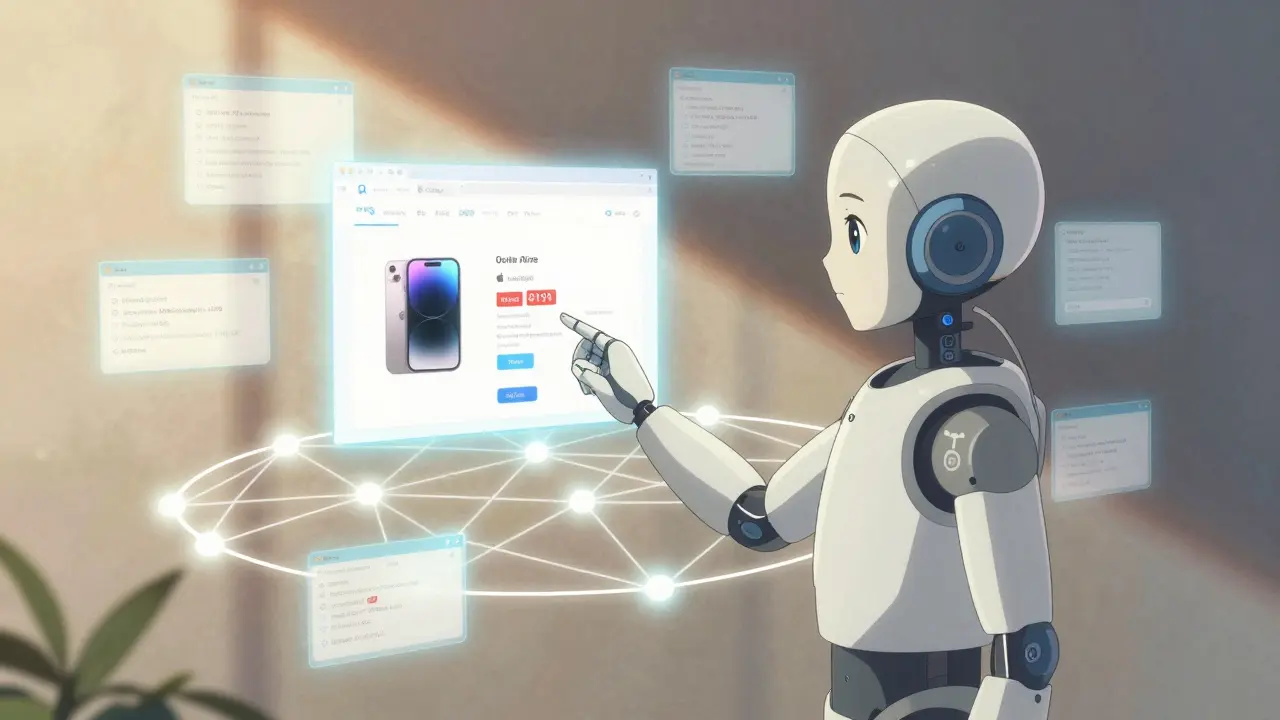

Les agents d’intelligence artificielle qui naviguent sur le web comme des humains ne sont plus une science-fiction. Depuis 2024, des systèmes comme BrowserArena et une plateforme d’évaluation en temps réel pour les agents LLM qui effectuent des tâches sur le web ouvert, comme chercher un produit, comparer des prix ou vérifier une information actualisée ont rendu cela tangible. Ce n’est pas juste une amélioration du chatbot classique. C’est une révolution : des modèles de langage capables de cliquer, de scroller, de lire du HTML et de choisir entre une recherche Google ou une navigation manuelle sur un site. Tout ça pour répondre à une question simple : est-ce que l’IA sait ce qu’elle dit, ou elle invente juste ?

Qu’est-ce que la navigation web ancrée ?

La navigation web ancrée, c’est quand un agent LLM ne se contente pas de répondre avec ce qu’il a appris pendant son entraînement. Il va chercher l’information en direct sur Internet. C’est ce qu’on appelle le grounding - un terme utilisé par Google Vertex AI pour dire : lier les réponses du modèle à des sources vérifiables. Pas de spéculations. Pas de hallucinations. Juste des faits tirés de pages web réelles.

Imaginons que vous demandiez à un agent : « Quel est le prix actuel de la dernière iPhone 16 ? » Un modèle non ancré va vous donner une réponse basée sur des données vieilles de plusieurs mois. Un agent ancré, lui, va ouvrir Google, taper la requête, cliquer sur le premier résultat, lire le prix sur le site d’Apple, et vous le donner en temps réel. C’est ce que font les meilleurs systèmes aujourd’hui - avec un taux de réussite de 72,3 % sur les requêtes complexes, contre seulement 41,7 % sans accès au web.

Comment ça marche ? Les pièces du puzzle

Un agent de navigation web ancrée n’est pas un seul modèle. C’est un système composé de plusieurs parties :

- Un modèle de langage (comme Llama-4 ou Flan-T5) qui décide quoi faire : chercher, cliquer, lire, ou répondre.

- Un navigateur automatisé comme BrowserUse, Playwright ou Selenium, qui exécute les actions réelles sur les sites web.

- Un système de recherche augmentée (RAG) qui stocke et récupère des fragments de pages utiles pour guider le modèle.

- Un traitement du DOM pour réduire la taille des pages web et ne garder que les éléments essentiels (ex. : prix, dates, boutons).

- Une interface visuelle (en développement) qui permet au modèle de « voir » les éléments sur la page, comme un humain.

Par exemple, GLAINTEL, un agent open-source développé en 2024, utilise un modèle de 780 millions de paramètres - bien plus petit que GPT-4 - mais il arrive à naviguer sur des sites de commerce électronique avec 82 % de précision. Il comprend les boutons « Ajouter au panier », les prix en temps réel, et même les promotions cachées derrière des menus déroulants.

Les défis techniques : ce qui casse tout

Malgré les progrès, les agents ancrés ont encore du mal avec certains sites. Voici les problèmes les plus courants :

- JavaScript lourd : 78 % des développeurs signalent des échecs sur des sites qui chargent du contenu dynamiquement. Les taux de réussite tombent à 53 %.

- CAPTCHAs : 89 % des agents échouent à les résoudre. Pas de solution fiable encore.

- Changements de structure : si un site change son design, l’agent peut ne plus trouver le bouton « Prix » ou le champ de recherche. Les taux d’échec augmentent de 27 % pour chaque modification majeure.

- Pages protégées par login : 89 des 147 avis sur Trustpilot citent ce problème. Les agents ne peuvent pas se connecter à des comptes utilisateurs.

- Coût et lenteur : une requête complexe coûte 0,042 $ et prend 14,7 secondes. Un simple chatbot, lui, coûte 0,008 $ et répond en 2,3 secondes.

Un développeur sur Reddit a passé 37 heures à fine-tuner GLAINTEL pour qu’il comprenne les pages de produits d’un site de vente en ligne. C’est un travail de bûcheron. Mais quand ça marche, ça réduit le temps de recherche de produits de 43 %.

Google, Salesforce et les nouveaux venus

Le marché des agents d’IA naviguant sur le web est en pleine explosion. Il devrait atteindre 1,7 milliard de dollars en 2025, selon Gartner. Les grands acteurs ne sont pas en reste :

- Google intègre le grounding dans Vertex AI, avec une version 2.0 prévue pour janvier 2025, plus intelligente dans la reconnaissance d’entités.

- Salesforce propose Agentforce, utilisé dans le support client pour retrouver des réponses dans les bases de connaissances en ligne.

- BrowseAI et Webfuse sont des startups qui se spécialisent dans la navigation automatisée. Webfuse a même lancé une API de « downsampling visuel » en novembre 2024 : elle ajoute des numéros sur les éléments de page pour aider l’IA à les repérer comme un humain.

47 % des entreprises du Fortune 500 testent déjà ces systèmes. Le commerce électronique en est le principal utilisateur (68 % des déploiements), suivi par le support client (23 %) et l’analyse financière (9 %).

Le problème du web libre

Il y a un paradoxe. Ces agents naviguent sur le web… sans payer. Ils ne cliquent pas sur les publicités. Ils ne génèrent pas de revenus pour les sites qu’ils consultent. Selon Circle, une analyse de novembre 2024, les agents d’IA génèrent déjà un trafic massif - sans rémunérer les éditeurs. Cela pourrait menacer l’écosystème publicitaire qui finance 547 milliards de dollars de contenus en ligne.

Les experts s’inquiètent aussi d’une autre chose : l’homogénéisation. 89 % des requêtes d’agents passent par seulement trois moteurs de recherche. Si Google change son algorithme, tout le système s’effondre. Aisera a montré que la précision peut varier de 19 points selon le moteur utilisé.

La solution ? Des mécanismes de compensation. Certains pensent que les agents devront payer une petite taxe pour accéder à certains contenus. D’autres imaginent des balises HTML spéciales - des « balises agent-friendly » - qui permettraient aux sites de dire : « Je suis conçu pour les IA, voici mes données structurées. »

Comment commencer ?

Si vous êtes développeur et que vous voulez tester ça :

- Installez Playwright ou BrowserUse (compatibilité 97 % avec les navigateurs).

- Connectez un modèle LLM (Llama-3, Flan-T5, ou même GPT-4o via API).

- Utilisez Chroma (v0.4.22) pour stocker les fragments de pages utiles.

- Implémentez un système de DOM downsampling : réduisez les pages à leur essence (titre, prix, boutons).

- Testez sur des tâches simples : « Trouve le prix du produit X sur le site Y ».

La courbe d’apprentissage est longue : 8 à 12 semaines pour être efficace, selon une enquête sur GitHub. Il faut être à l’aise avec Python, HTML, JavaScript, et les frameworks d’IA comme LangChain. La documentation de Google est bonne (4,2/5), mais les projets open-source sont souvent mal documentés (3,1/5).

Rejoignez la communauté : le subreddit r/WebNavigationAI a 3 247 membres, et les canaux Discord de BrowserUse et GLAINTEL sont actifs. Vous trouverez des forks avec des filtres DOM personnalisés, des astuces pour contourner les CAPTCHAs, et même des scripts pour simuler des clics humains.

Que va-t-il se passer en 2025 ?

Les prédictions sont claires :

- Un protocole standard pour les agents web sera probablement adopté d’ici mi-2025 (68 % de chances selon Forrester).

- Des sites commenceront à intégrer du markup dédié aux IA - des balises spécifiques pour faciliter la lecture automatique (47 % de chances).

- L’UE va probablement légiférer sur les systèmes de navigation autonome dans le cadre du règlement européen sur l’IA (52 % de chances).

Et si on vous demande : « Est-ce que l’IA va remplacer les moteurs de recherche ? » La réponse est non. Elle va les transformer. À l’avenir, vous ne taperez plus « prix iPhone 16 ». Vous direz : « Trouve-moi le meilleur prix, avec livraison sous 24h, dans un magasin fiable. » Et un agent, ancré dans le web, le fera pour vous.

C’est une nouvelle forme d’interaction. Pas plus magique que Google en 1998. Mais plus précise, plus utile, et plus profonde.

Quelle est la différence entre un agent ancré et un simple chatbot ?

Un chatbot répond avec les données sur lesquelles il a été entraîné, ce qui peut être obsolète ou faux. Un agent ancré va chercher l’information en temps réel sur le web, consulte des pages réelles, et cite ses sources. C’est la différence entre se souvenir et aller vérifier.

Les agents peuvent-ils naviguer sur n’importe quel site ?

Non. Ils échouent souvent sur les sites avec JavaScript très complexe, les pages protégées par login, les CAPTCHAs, ou ceux qui changent fréquemment leur structure. Ils sont aussi incapables de lire des images ou des PDF sans outils visuels supplémentaires.

Est-ce que Google va bloquer les agents LLM ?

Google n’a pas encore bloqué les agents, mais il limite les requêtes par IP et utilise des CAPTCHAs. Certains agents contournent cela en imitant le comportement humain - ralentir les clics, varier les temps de chargement. Mais si les agents deviennent trop massifs, Google pourrait imposer des restrictions plus strictes, comme il l’a fait pour les bots d’indexation.

Les agents ancrés sont-ils plus chers à utiliser ?

Oui. Une requête complexe coûte environ 0,042 $, contre 0,008 $ pour une simple réponse LLM. Le coût vient de l’automatisation du navigateur, de l’utilisation de l’API Google, et du traitement du DOM. Pour les entreprises, cela reste rentable si ça remplace des employés dans la recherche d’informations.

Peut-on utiliser ça pour automatiser des achats en ligne ?

Techniquement oui, mais ce n’est pas recommandé. Les agents ne peuvent pas passer de commande sur des sites avec login, et ils ne comprennent pas les conditions d’utilisation ou les garanties. De plus, cela soulève des questions éthiques : qui est responsable si un agent achète par erreur un produit cher ?

Quel est le taux de réussite actuel des agents ancrés ?

Sur des tâches simples comme trouver un prix ou une date, les meilleurs agents réussissent à 72-75 %. Sur des tâches multi-étapes (ex. : comparer 3 produits, vérifier les avis, choisir la livraison la moins chère), le taux tombe à 50-60 %. Pour les tâches visuelles (ex. : trouver un bouton caché dans une image), il chute à 39,7 %.