Les grands modèles linguistiques (LLM) comme GPT, Claude ou Llama transforment la façon dont les entreprises interagissent avec les gens. Mais derrière chaque réponse générée, il y a des risques invisibles : des préjugés cachés, des réponses discriminatoires, des décisions qui nuisent à des groupes marginalisés. Ce n’est pas un problème technique. C’est un problème humain. Et les seules solutions qui fonctionnent réellement sont celles qui incluent les personnes directement affectées - pas seulement les ingénieurs ou les cadres.

Pourquoi les processus d’avis des parties prenantes sont indispensables

Un modèle d’IA peut être techniquement parfait - précis, rapide, bien entraîné - mais s’il génère des réponses qui stigmatisent les minorités, ignore les contextes culturels ou renforce des inégalités, il échoue. Et ce n’est pas une question de hasard. Les biais viennent des données, des choix de conception, et surtout, du manque de diversité dans la salle où les décisions sont prises.

En 2025, les études montrent que les organisations qui mettent en œuvre des processus formels d’avis des parties prenantes réduisent les incidents éthiques de 42 %. Dans le secteur de la santé, où un mauvais diagnostic peut coûter une vie, 87 % des études éthiques intègrent systématiquement les perspectives des patients, des infirmiers, des médecins et des communautés. Sans cela, les modèles risquent de répéter les erreurs du passé - comme les algorithmes qui sous-estimaient les besoins médicaux des patients noirs, ou ceux qui refusaient des prêts à des quartiers à faible revenu sous prétexte de « risque ».

La réglementation a suivi. L’UE a rendu obligatoire l’avis des parties prenantes pour les systèmes d’IA à haut risque avec l’entrée en vigueur de la loi sur l’IA en août 2024. La Californie a suivi en janvier 2025. Ce n’est plus une bonne pratique. C’est une exigence légale.

Comment fonctionne un processus d’avis des parties prenantes

Il ne s’agit pas de faire une enquête rapide ou de réunir un panel de 3 personnes pour dire « ça va ». Un vrai processus a quatre phases clés, comme le décrit le cadre SKIG, adopté par de nombreuses équipes techniques en 2024.

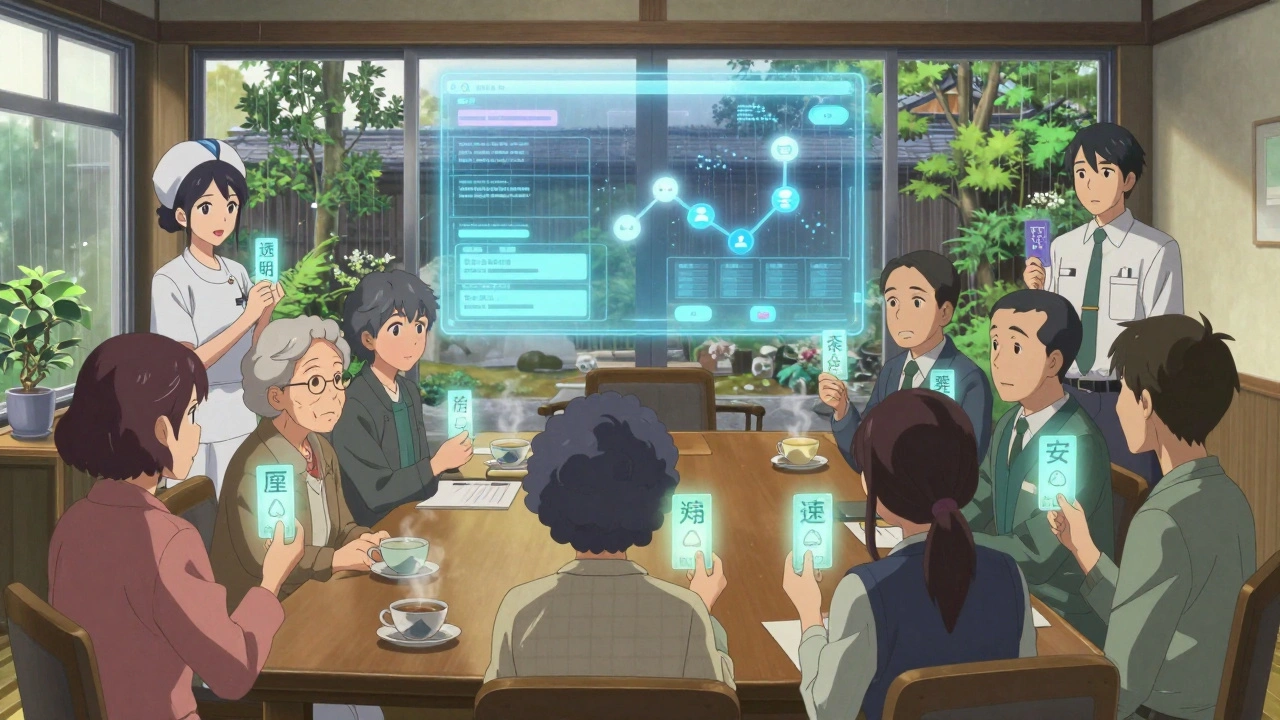

- Identifier les parties prenantes : Qui est affecté ? Pas seulement les clients, mais aussi les employés dont le travail est automatisé, les communautés dont les données sont utilisées, les groupes marginalisés dont les langues ou dialectes sont absents des données d’entraînement. Le cadre SKIG utilise le jeu de données Social Chemistry 101 pour simuler 15 types de profils humains avec précision - jusqu’à 95,7 % d’exactitude après sa mise à jour en février 2025.

- Analyser les motivations : Pourquoi chaque groupe se soucie-t-il de ce modèle ? Un patient veut de la transparence. Un médecin veut du contrôle. Un régulateur veut de la traçabilité. Un développeur veut de la vitesse. Ces intérêts ne sont pas toujours compatibles.

- Évaluer les risques : Qu’est-ce qui peut mal tourner ? Dans le pire des cas, un chatbot de santé recommande un traitement dangereux à une femme âgée parce qu’il n’a jamais été testé sur des données de personnes de plus de 70 ans. Dans le meilleur des cas, il identifie un symptôme rare que les médecins ont manqué.

- Évaluer l’éthique : Est-ce juste ? Est-ce respectueux ? Est-ce responsable ? Cette étape ne dépend pas d’un algorithme. Elle exige des discussions humaines, parfois difficiles, entre des personnes avec des valeurs différentes.

Le temps moyen pour identifier un risque éthique avec ce processus est de 14,3 heures. Sans lui, cela prend 32,7 heures - et souvent, le risque n’est jamais repéré avant le lancement.

Différences entre les cadres : santé, finance, entreprise

Tous les processus ne se valent pas. Le cadre utilisé dans les hôpitaux est très différent de celui adopté par une banque ou une startup technologique.

Dans la santé, les processus se concentrent sur la validation clinique. Un modèle qui prédit une maladie doit être approuvé par des médecins, des infirmières et des patients. Les études montrent 89 % de satisfaction chez les professionnels de santé. Mais ces cadres sont trop lourds pour un service de prêt en ligne.

En finance, les entreprises cherchent des résultats mesurables. Un cadre de la Journal of Applied Business and Economics a permis à une entreprise de éviter une amende de 2,3 millions de dollars en détectant que ses explications de refus de prêt étaient culturellement inappropriées pour 17 % de sa clientèle. Le gain : 23 % d’économies grâce à la prévention des incidents.

Le cadre SKIG se distingue par sa capacité à faire fonctionner des modèles plus petits (moins de 7 milliards de paramètres) avec une précision morale presque équivalente aux plus gros. Il intègre des simulations automatiques de conséquences - 15,7 scénarios par minute - et réduit les erreurs de raisonnement de 34 %.

Le problème ? Les cadres d’entreprise ont tendance à ignorer les contextes historiques. Un modèle peut être « juste » sur les données actuelles, mais répéter des discriminations raciales ou de genre ancrées dans les données du passé. Selon le professeur James Chen de Stanford, 61 % des cadres actuels négligent complètement cette dimension.

Les pièges courants et ce qui ne marche pas

Beaucoup d’entreprises croient qu’elles font de l’éthique parce qu’elles ont créé un comité d’éthique. Elles ont même un logo sur leur site : « Nous respectons l’éthique de l’IA ».

C’est de la comédie.

44 % des mises en œuvre corporatives, selon la Journal of Applied Business and Economics, ne font que « faire semblant ». Le comité est composé de personnes internes, sans pouvoir réel. Les décisions restent entre les mains des ingénieurs. Les parties prenantes externes sont consultées, mais pas écoutées.

Un autre piège : la bureaucratie. Sur Reddit, un développeur a raconté que son équipe a passé 11 semaines à organiser 8 réunions pour modifier une phrase dans un chatbot. Résultat ? Le modèle a été retardé, et aucun risque éthique majeur n’a été identifié.

Et puis il y a l’automatisation excessive. Certains outils prétendent cartographier automatiquement les parties prenantes. Mais ils manquent les nuances. Un outil peut dire « 50 % des utilisateurs sont des femmes », mais il ne voit pas que les femmes âgées dans les zones rurales sont complètement absentes des données. C’est pourquoi les avis sur Trustpilot pour ces plateformes ont une note moyenne de 3,2 sur 5.

La vraie clé ? Le pouvoir partagé. Comme le dit Dr. Elena Rodriguez du MIT : « Les processus les plus efficaces donnent aux parties prenantes un pouvoir de décision, pas seulement un rôle consultatif. » 73 % des succès viennent de là.

Comment commencer - étape par étape

Vous n’avez pas besoin d’un budget de 1 million de dollars. Voici comment démarrer, même si vous êtes une petite équipe.

- Identifiez 5 groupes de parties prenantes : Par exemple, dans un système de recrutement : candidats, recruteurs, équipes RH, employés actuels, groupes de défense des droits. Ne les oubliez pas.

- Établissez des canaux de communication : Utilisez des outils comme Notion, Miro ou des réunions mensuelles. 82 % des équipes qui réussissent utilisent une plateforme dédiée.

- Définissez 3 à 5 indicateurs clés : Par exemple : taux de réponses discriminatoires, temps de réponse pour les utilisateurs non anglophones, satisfaction des parties prenantes externes.

- Intégrez le processus dès le début : Ne l’ajoutez pas à la fin. Faites-le pendant la collecte des données, pendant l’entraînement, et avant chaque mise à jour.

- Revoyez tous les 45 à 60 jours : Les dynamiques changent. Un modèle qui fonctionnait bien en janvier peut devenir problématique en mars après une vague de discours haineux en ligne. Les experts s’accordent : les évaluations ponctuelles ne suffisent plus.

La courbe d’apprentissage prend 8 à 12 semaines. La plupart des petites entreprises ont besoin d’un consultant externe pour les premières étapes. Mais une fois en place, le processus devient autonome.

Les coûts et les bénéfices réels

Oui, cela prend du temps. Oui, cela coûte de l’argent. Les petites entreprises dépensent jusqu’à 22 % de leur budget IA pour ces processus, contre 8-12 % pour les grandes entreprises.

Mais regardez ce que ça évite :

- Des amendes de millions de dollars (comme celle évitée par la banque)

- Des procès pour discrimination

- Des campagnes de dénigrement sur les réseaux sociaux

- La perte de confiance des clients

En 2025, 58 % des entreprises disent que ces processus génèrent des bénéfices commerciaux - pas seulement en réduisant les risques, mais en améliorant la qualité du produit. Un modèle qui comprend les besoins réels des gens est plus utile. Plus fiable. Plus utilisé.

Et la confiance ? Selon une étude de Nature, les scores de confiance des utilisateurs passent de 4,2 à 7,8 sur 10 après l’implémentation d’un vrai processus d’avis des parties prenantes.

Que va-t-il se passer dans les prochaines années ?

Le marché mondial de l’éthique de l’IA va passer de 1,27 milliard de dollars en 2024 à 3,84 milliards en 2027. Les grandes entreprises ne l’ont pas encore compris, mais elles vont être forcées de le faire.

Les futures évolutions incluent :

- Des outils qui prédisent automatiquement les impacts sociaux des modèles - Google vise 80 % de précision d’ici fin 2025.

- Des normes pour mesurer le retour sur investissement éthique - un indicateur comme « combien de vies améliorées ou de préjugés évités ? »

- Une intégration directe dans les pipelines de déploiement continu - Microsoft teste déjà des systèmes qui bloquent automatiquement une mise à jour si un risque éthique n’est pas évalué.

Le défi majeur ? Empêcher l’« éthique de spectacle ». Quand les entreprises mettent en place un processus juste pour dire qu’elles sont « éthiques », sans en changer vraiment le fonctionnement. 79 % des chercheurs en éthique de l’IA le considèrent comme le plus grand risque pour l’avenir.

La solution ? La transparence. Publiez vos rapports d’avis. Montrez les critiques des parties prenantes. Acceptez les échecs. Ce n’est pas un signe de faiblesse. C’est le seul moyen de construire une IA digne de confiance.

Qu’est-ce qu’une partie prenante dans le contexte de l’IA ?

Une partie prenante est toute personne ou groupe affecté par un modèle d’IA - pas seulement les utilisateurs finaux. Cela inclut les employés dont le travail est automatisé, les communautés dont les données sont utilisées, les régulateurs, les défenseurs des droits, les patients, les clients, et même les générations futures. Leur voix doit être entendue, pas seulement collectée.

Les processus d’avis des parties prenantes sont-ils obligatoires ?

Oui, dans de nombreuses juridictions. L’Union européenne l’exige pour les systèmes d’IA à haut risque depuis août 2024. La Californie l’a rendu obligatoire en janvier 2025. D’autres pays comme Singapour et le Canada ont des lignes directrices similaires. Même si ce n’est pas encore légal chez vous, c’est devenu une exigence du marché.

Peut-on automatiser entièrement l’avis des parties prenantes ?

Non. Les outils automatisés peuvent aider à identifier les groupes ou à simuler des scénarios, mais ils ne peuvent pas comprendre la souffrance, la peur ou l’espoir humains. Les décisions éthiques requièrent du jugement, de l’empathie et des discussions. L’automatisation est un outil, pas une solution.

Combien de temps faut-il pour mettre en œuvre un processus d’avis des parties prenantes ?

Entre 8 et 16 semaines pour une mise en œuvre complète, selon la taille de l’équipe et la complexité du modèle. Les grandes entreprises peuvent prendre plus de temps à cause des processus internes. Les petites équipes peuvent démarrer avec une version simplifiée en 4 à 6 semaines.

Quels sont les meilleurs outils gratuits pour commencer ?

Le cadre SKIG est open-source et disponible sur GitHub. Le Partnership on AI propose un kit gratuit d’engagement des parties prenantes, téléchargé plus de 12 000 fois en 2024. L’IEEE a aussi publié un cadre d’alignement éthique largement utilisé. Commencez avec l’un de ces outils, adaptez-le à votre contexte, et ajoutez des voix humaines réelles.

Comment savoir si mon processus fonctionne vraiment ?

Regardez les indicateurs : réduction des incidents de biais, augmentation de la confiance des utilisateurs, temps réduit pour identifier les risques. Mais surtout, demandez aux parties prenantes : « Vous sentez-vous écouté ? Avez-vous eu un impact sur les décisions ? » Si la réponse est non, votre processus est une façade.