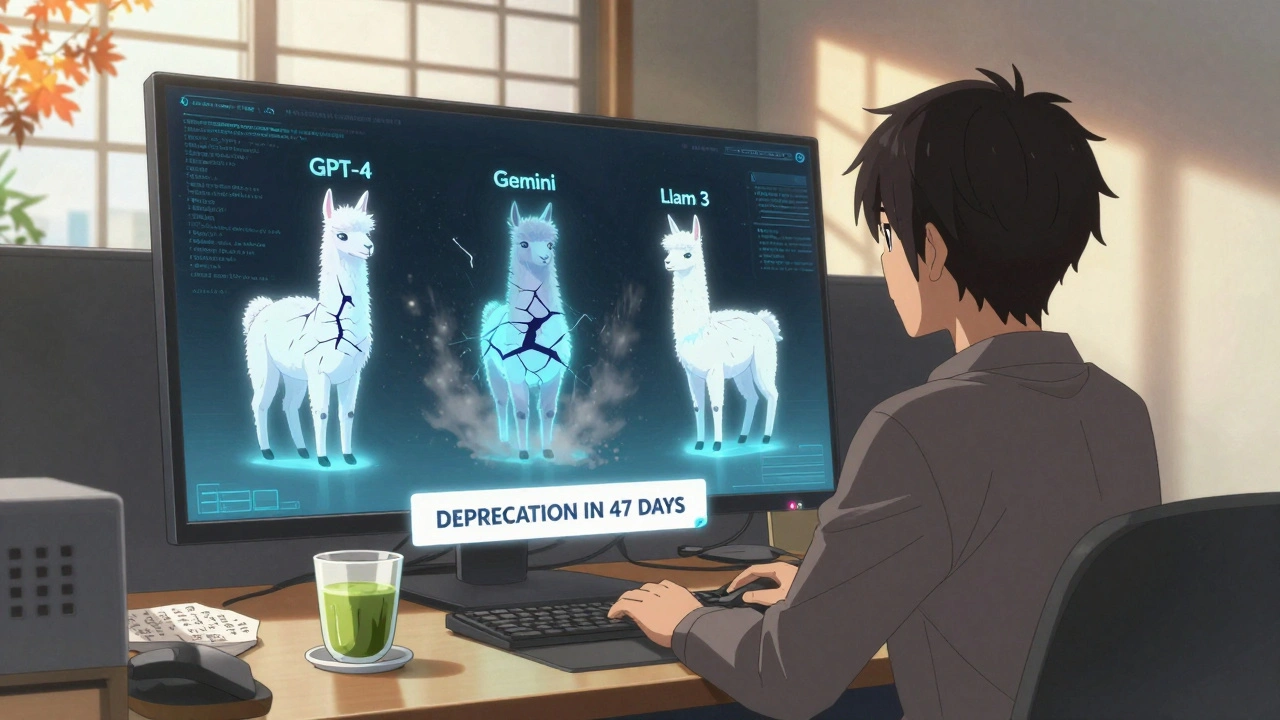

Dépréciation LLM : Comment gérer les modèles de langage qui perdent de la valeur en production

Quand un dépréciation LLM, la perte progressive de performance, de pertinence ou de confiance d’un modèle de langage après son déploiement. Also known as détérioration du modèle, it se produit quand les données d’entraînement deviennent obsolètes, les attentes des utilisateurs changent, ou que le modèle est mal adapté à son contexte d’usage. Ce n’est pas un bug. C’est une réalité. Vous avez déployé un LLM il y a six mois ? Il est déjà moins bon qu’avant. Pas parce qu’il est cassé. Mais parce que le monde a changé autour de lui.

La compression modèle, la réduction de la taille d’un modèle pour réduire les coûts et améliorer la vitesse d’inférence est souvent vue comme une solution. Mais elle ne règle pas la dépréciation. Un modèle plus petit, mais entraîné sur des données vieillies, donne toujours des réponses dépassées. Même un fine-tuning, l’ajustement d’un modèle pré-entraîné sur un jeu de données spécifique pour améliorer sa précision dans un domaine ne suffit pas si vous ne réévaluez pas les résultats régulièrement. Vous ne pouvez pas juste relancer un modèle et espérer qu’il s’adapte. Il faut le surveiller comme une machine industrielle.

La dépréciation LLM ne se voit pas tout de suite. Elle se cache dans les réponses qui deviennent trop génériques, dans les erreurs factuelles qui apparaissent dans des domaines où elles n’existaient pas, dans les utilisateurs qui commencent à ignorer les suggestions de l’IA. C’est un déclin silencieux. Et il est plus courant que vous ne le pensez. Les entreprises qui utilisent des LLM pour le service client, la rédaction juridique ou la génération de contenus médicaux sont les plus touchées. Un modèle qui ne connaît pas la dernière loi ou la nouvelle terminologie médicale devient un risque, pas un outil.

Vous ne pouvez pas arrêter le temps. Mais vous pouvez mesurer l’usure. Comment ? En mettant en place des évaluation LLM, des tests répétés pour mesurer la performance, la fiabilité et la pertinence d’un modèle de langage dans son contexte d’usage réguliers. Pas des benchmarks abstraits. Des tests concrets : des questions posées par vos vrais utilisateurs, des scénarios réels de production, des comparaisons avec les réponses humaines. Vous verrez vite quand un modèle commence à dériver.

La dépréciation LLM n’est pas une fatalité. C’est un problème de gestion. Et comme tout problème de gestion, il se résout avec des processus, pas avec des miracles. Ce que vous trouverez ici, ce ne sont pas des théories. Ce sont des cas réels : comment une équipe a détecté que son modèle de rédaction juridique devenait dangereux, comment une autre a réduit ses coûts en remplaçant un LLM trop lourd par un modèle plus petit mais mieux adapté, comment des checklists simples ont évité des erreurs coûteuses. Vous verrez comment d’autres ont arrêté de courir après la dernière version de GPT et ont commencé à construire des systèmes durables. Ce n’est pas de la magie. C’est de la rigueur.