DevSecOps : Intégrer la sécurité dans le cycle de développement avec l'IA

Quand on parle de DevSecOps, une approche qui intègre la sécurité dès les premières étapes du développement logiciel, au lieu de la traiter comme une étape finale. Also known as Sécurité intégrée au cycle de développement, it transforme la façon dont les équipes tech construisent, testent et déplient du code. Ce n’est plus une question de "ajouter la sécurité après". C’est de faire en sorte que chaque ligne de code, chaque déploiement, chaque modèle d’IA soit vérifié avant même qu’il ne soit écrit.

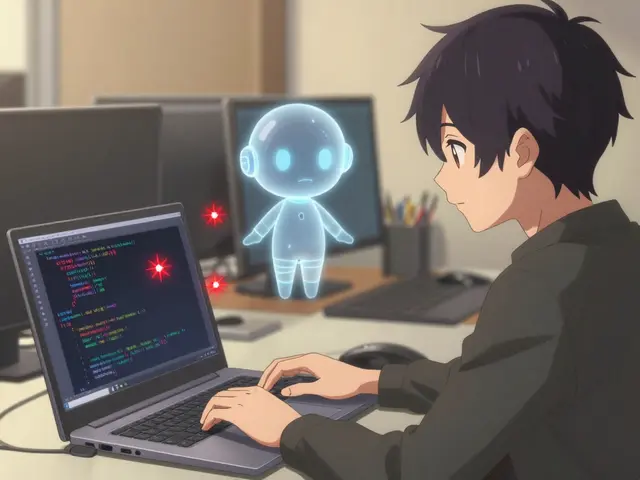

Le code généré par l’IA, un outil puissant pour accélérer le développement, mais aussi une source majeure de vulnérabilités cachées n’est pas plus sûr parce qu’il est rapide. Il est souvent plus dangereux. Un prompt mal formulé peut générer du code qui expose des clés API, ignore les contrôles d’accès ou oublie les validations d’entrée. C’est là que le CI/CD, le pipeline automatisé qui construit, teste et déploie le code devient critique. Sans audits de sécurité intégrés dans ce pipeline, vous déployez des bombes à retardement. Les équipes qui réussissent aujourd’hui combinent DevSecOps avec des checklists spécifiques au code IA — comme celles basées sur l’OWASP Top 10 pour l’IA — et des outils qui détectent les erreurs typiques des modèles génératifs : hallucinations dans les commentaires, dépendances non vérifiées, ou logique de sécurité absente.

La sécurité de l’IA générative, la capacité à garantir que les modèles n’induisent pas en erreur, ne fuient pas de données sensibles ou ne génèrent pas de contenu malveillant n’est plus optionnelle. Elle est au cœur des SLA avec les fournisseurs d’IA, des audits de conformité, et même des contrats avec les clients. Quand vous utilisez un modèle pour générer du code de production, vous ne faites pas que réduire les délais — vous prenez aussi une responsabilité légale. Et cette responsabilité, elle ne peut pas être déléguée à l’IA. Elle doit être construite dans les processus. C’est pourquoi les meilleures équipes ont intégré des audits de sécurité, des vérifications automatisées et humaines pour valider chaque sortie d’IA avant déploiement directement dans leurs workflows de vibe coding.

Vous trouverez ici des guides concrets sur comment mettre en place ces processus : comment transformer un prototype généré par l’IA en composant sécurisé, comment éviter les modules orphelins qui deviennent des failles, comment écrire des prompts qui réduisent les risques, et comment faire en sorte que la sécurité ne ralentisse pas — mais qu’elle renforce — votre vitesse. Pas de théorie. Pas de jargon. Juste des méthodes testées par des ingénieurs qui ont déjà eu des incidents. Ce que vous lirez ici, c’est ce qui fonctionne quand la pression est forte, que le code est en production, et que la faute ne peut plus être ignorée.