LLMOps : Ce qu'il faut savoir pour déployer et gérer les grands modèles linguistiques en production

Quand vous utilisez un grand modèle linguistique, un système d'intelligence artificielle capable de comprendre et générer du texte avec une précision humaine. Also known as LLM, it est devenu l'outil central pour automatiser le service client, rédiger du contenu, ou analyser des contrats. Mais un modèle qui fonctionne bien en test ne vaut rien s'il s'effondre en production. C'est là qu'intervient le LLMOps, l'ensemble des pratiques pour déployer, surveiller, mettre à jour et sécuriser les grands modèles linguistiques en environnement réel. Ce n'est pas juste du DevOps avec un LLM dessus. C'est une discipline entière, avec ses propres risques, ses outils, et ses règles.

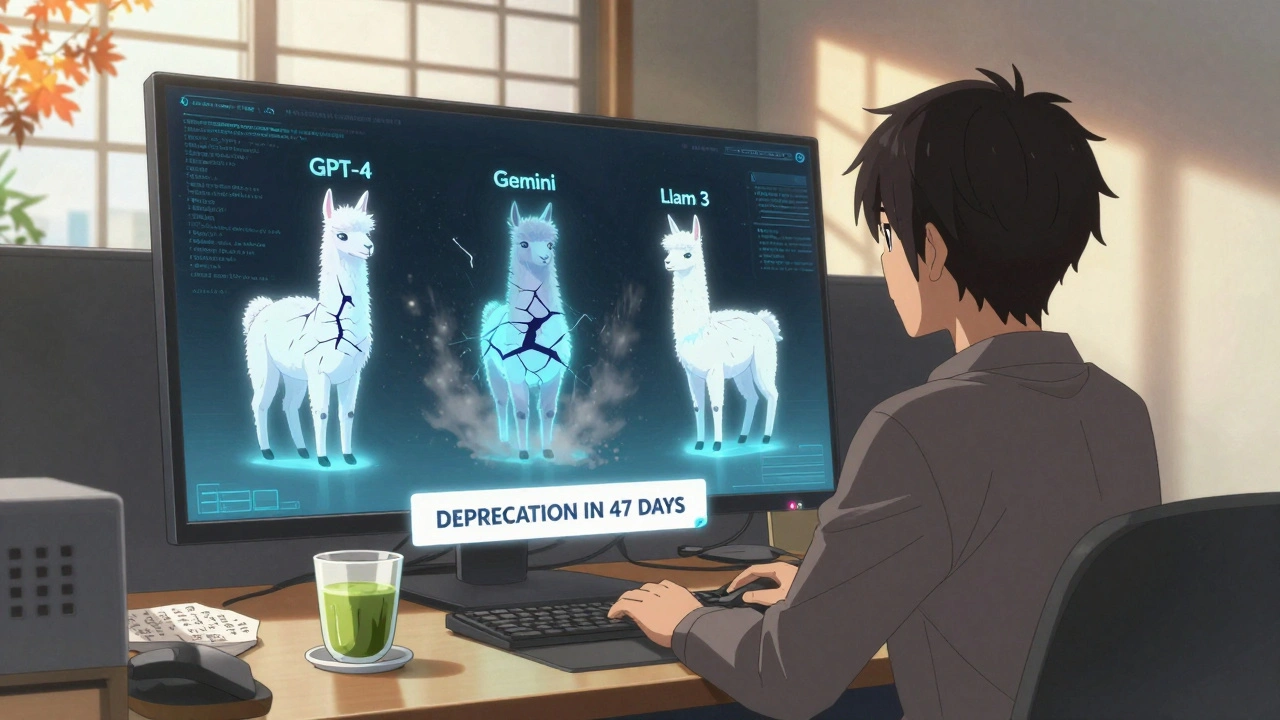

Le LLMOps comprend trois piliers invisibles : la gouvernance du code, qui détermine qui est responsable des modifications apportées aux prompts et aux pipelines, la vérification des agents, qui garantit que les décisions prises par l'IA sont conformes, reproductibles et sécurisées, et la gestion des fournisseurs, qui évite le verrouillage technologique avec des SLA clairs et des plans de sortie. Sans ces trois éléments, vous avez un modèle qui marche… jusqu'au jour où il se met à inventer des faits, à fuiter des données, ou à devenir trop cher à faire tourner.

Les articles ci-dessous ne parlent pas de théorie. Ils montrent comment des équipes réelles ont transformé des prototypes de vibe coding en systèmes stables, comment elles ont mis en place des tests de régression pour bloquer les failles de sécurité, comment elles ont équilibré les données pour que leur modèle parle aussi bien l'arabe que l'anglais, et comment elles ont construit des checklists pour éviter que l'IA ne laisse des clés API exposées dans le code. Vous y trouverez des méthodes pour mesurer la qualité du code généré, pour choisir entre compresser un modèle ou en changer, et pour intégrer l'humain dans la boucle sans ralentir la production. Ce n'est pas un guide pour débutants. C'est une boîte à outils pour ceux qui doivent faire fonctionner l'IA dans le monde réel — et qui veulent le faire sans se faire surprendre.