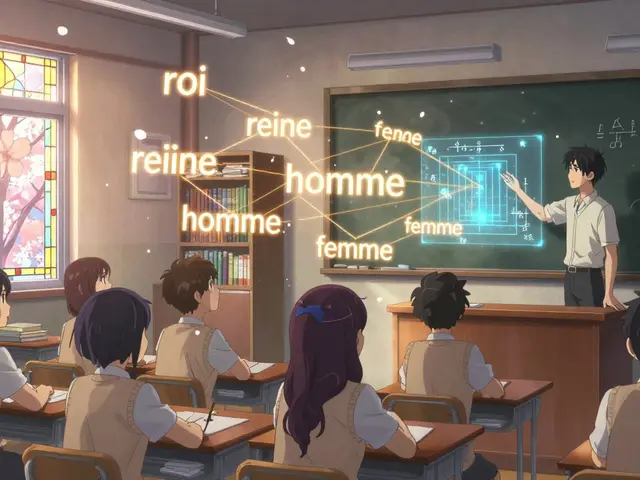

Les grands modèles linguistiques (LLM) comme GPT, Claude ou Gemini transforment les entreprises. Ils rédigent des courriels, génèrent des rapports, recrutent des candidats, et même conseillent des patients. Mais qui veille à ce qu’ils ne biaisent pas les recrutements, ne fuient pas les données sensibles, ou ne mentent pas en toute légalité ? La réponse n’est pas dans un seul service informatique. C’est dans un comité interfonctionnel.

Pourquoi un comité ? Pas juste un autre groupe de réunion

Un comité interfonctionnel pour l’IA n’est pas une réunion mensuelle où tout le monde sourit poliment. C’est une structure formelle, avec des rôles clairs, des processus documentés, et un pouvoir réel. Il réunit des personnes de la direction juridique, de la sécurité informatique, de la vie privée, du développement produit, des ressources humaines, et même de la direction générale. Pourquoi ? Parce qu’un LLM ne pose pas seulement un problème technique. Il pose un problème légal, éthique, opérationnel et humain en même temps.En 2024, une banque a déployé un LLM pour trier les CV. Il a systématiquement éliminé les candidats ayant suivi des formations dans des écoles publiques. Le service RH ne l’a pas vu. Le service juridique non plus. La sécurité informatique pensait que c’était un outil de RH. Le comité interfonctionnel, lui, l’a bloqué avant le lancement. Comment ? Parce que les trois départements avaient déjà discuté des risques ensemble, avant que le code ne soit écrit.

Qui doit être dans le comité ? Pas tout le monde, mais les bons

Un comité efficace ne compte pas plus de 12 membres. Trop nombreux, il devient lent. Trop petit, il manque de perspectives. Voici les rôles indispensables :- Juridique : pour s’assurer que tout respecte l’Acte européen sur l’IA, la loi HIPAA, ou les règles locales.

- Vie privée : pour vérifier que les données d’entraînement ne contiennent pas d’informations personnelles sensibles ou illégales.

- Sécurité informatique : pour détecter les failles dans les prompts, les fuites de données via les réponses, ou les attaques par injection.

- Développement produit : pour dire quelles fonctionnalités sont réellement utiles, et quelles sont juste des idées brillantes mais dangereuses.

- Respect de l’éthique et conformité : pour poser la question : « Et si cela se retrouvait en une du New York Times ? »

- Ressources humaines : pour repérer les biais dans les décisions de recrutement, de promotion ou d’évaluation.

- Direction générale : pour garantir que le comité a les ressources et l’autorité nécessaires pour dire non.

Les entreprises les plus performantes ont un modèle appelé « Nouvelle Triade » : juridique, sécurité et vie privée forment le cœur du comité. Ensemble, ils réduisent les échecs de gouvernance de 42 % par rapport aux approches traditionnelles. Les autres rôles viennent en appui selon les projets.

Comment ça marche ? Pas de réunions infinies

Le comité ne décide pas de tout. Sinon, il devient un goulot d’étranglement. Voici comment ça fonctionne en pratique :- Chaque projet d’IA est classé selon son risque : faible, moyen ou élevé.

- Les projets à faible risque (ex. : génération de résumés de réunions internes) sont approuvés par un petit groupe de travail, avec un formulaire automatisé.

- Les projets à risque élevé (ex. : détection de fraude financière, évaluation médicale, recrutement) passent devant le comité complet.

- Chaque décision est documentée : pourquoi oui ? pourquoi non ? Quels risques ont été identifiés ? Qui a signé ?

Les meilleures entreprises utilisent une matrice RACI : Responsable, Accountable (celui qui doit répondre), Consulté, Informé. Pour un projet de recrutement, le RH est responsable, le juridique est accountable, la sécurité est consultée, et la direction est informée. Pas de doute. Pas de blâme. Pas de silence.

Les documents clés : pas de papier, mais de la trace

Un comité sans documents est un comité sans pouvoir. Voici les trois outils indispensables :- L’évaluation d’impact sur l’IA : un formulaire qui remplace les questions « Est-ce bien ? » par « Quels sont les risques de biais ? Quelle est la qualité des données ? Comment vérifier les réponses ? »

- Le registre des décisions : un document central où chaque décision est archivée, avec la date, les participants, et la justification. En cas d’audit, c’est votre bouclier.

- Les protocoles de révision : des checklists claires pour chaque phase : collecte des données, entraînement, test, déploiement, surveillance post-lancement.

76 % des entreprises qui ont mis en place ces documents ont réduit les risques réglementaires de 68 %. Pourquoi ? Parce qu’un juge ou un régulateur ne demande pas « Vous avez pensé à l’éthique ? ». Il demande : « Montrez-moi votre preuve. »

Les erreurs qui tuent les comités

Beaucoup de comités échouent. Pas parce que les gens sont mal intentionnés. Parce qu’ils sont mal conçus.- Manque de pouvoir réel : si le comité peut seulement conseiller, il est inutile. Il doit pouvoir bloquer un projet. 52 % des comités échouent parce que personne n’a le droit de dire non.

- Participation inégale : les ingénieurs sont pressés. Les juristes sont surchargés. Les RH ne comprennent pas l’IA. Sans un sponsor exécutif fort (CIO, CTO, ou directeur éthique), les réunions deviennent des séances de thérapie de groupe.

- Manque de traçabilité : si une décision n’est pas écrite, elle n’a jamais eu lieu. 41 % des échecs viennent d’un problème non signalé parce que personne n’a su à qui le dire.

- Comité trop technique : si tout le monde parle de poids de modèle et de fine-tuning, vous avez perdu. Le comité doit parler de risques humains, pas de métriques.

En 2024, une grande banque a utilisé un LLM pour recruter. Le biais de genre a duré six mois. Pourquoi ? Parce que le RH pensait que c’était un outil technique, et que la sécurité pensait que c’était une affaire RH. Personne n’avait été désigné comme accountable. Résultat : un procès, une amende, et une perte de confiance.

Comment commencer ? Un plan simple en 12 semaines

Vous n’avez pas besoin d’un budget de 2 millions. Vous avez besoin d’un plan.- Semaines 1-2 : Identifiez vos 5-7 rôles clés. Trouvez les personnes qui peuvent vraiment parler pour leur service.

- Semaines 3-6 : Écrivez une charte. Quel est le but ? Qui décide quoi ? Quand ? Comment ?

- Semaines 7-10 : Créez votre premier formulaire d’évaluation d’impact. Basez-vous sur les modèles de NIST ou de l’UE. Adaptez-le à votre métier.

- Semaines 11-12 : Testez-le sur un petit projet. Pas sur un LLM de recrutement. Sur un outil de génération de réponses client pour un service d’assistance interne.

Les entreprises qui suivent ce plan voient leur temps d’approbation passer de 8 semaines à 11 jours. Et elles évitent des catastrophes.

Le vrai but : ne pas freiner l’innovation - l’accélérer

Beaucoup pensent que la gouvernance ralentit. C’est faux. Ce qui ralentit, c’est l’incertitude. Ce qui ralentit, c’est la peur de se faire poursuivre. Ce qui ralentit, c’est le fait de devoir tout réécrire parce qu’on a oublié un risque.Un bon comité interfonctionnel ne dit pas non. Il dit : « Voici comment faire ça en toute sécurité. » Il transforme l’IA d’un risque en un levier stratégique. Les entreprises qui l’ont compris voient une accélération de 37 % dans l’adoption de l’IA. Elles n’ont pas moins d’innovation. Elles ont plus de confiance.

En 2026, les régulateurs ne demanderont plus : « Avez-vous utilisé une IA ? » Ils demanderont : « Avez-vous un comité pour la contrôler ? » Et s’il n’existe pas, ce n’est pas votre IA qui sera en cause. C’est vous.

Les comités interfonctionnels sont-ils la solution ultime ?

Non. Mais ils sont la seule solution qui marche. Des chercheurs comme Dr. Timnit Gebru soulignent que certains comités sont de la poudre aux yeux : ils existent, mais n’ont aucun pouvoir. C’est un piège. Un comité sans pouvoir est pire qu’aucun comité - il donne une fausse impression de sécurité.La clé ? La transparence. La traçabilité. Et surtout, la volonté d’écouter les voix qui disent « attention ». Pas celles qui disent « c’est juste un outil ».

Un comité interfonctionnel peut-il remplacer un responsable de l’éthique de l’IA ?

Non. Le responsable de l’éthique est un expert, souvent un médiateur technique et moral. Le comité est un organe décisionnel. Ils se complètent : le responsable apporte l’expertise, le comité prend les décisions. Sans responsable, le comité manque de profondeur. Sans comité, le responsable n’a pas de pouvoir.

Les petites entreprises ont-elles besoin d’un tel comité ?

Oui, même si elles sont petites. Une PME qui utilise un LLM pour générer des contrats ou répondre aux clients est exposée aux mêmes risques qu’une multinationale. Le comité peut être plus léger : trois personnes, une réunion par mois, un simple formulaire d’évaluation. L’important, c’est d’avoir un processus, pas une bureaucratie.

Comment convaincre les ingénieurs de participer ?

Montrez-leur que ça les protège. Un ingénieur qui déploie un modèle biaisé peut perdre son emploi, ou être poursuivi. Un comité bien conçu, c’est un filet de sécurité. Il ne ralentit pas le code - il évite que le code ne vous ralentisse. Et si vous avez un sponsor exécutif, c’est plus facile : la participation devient une obligation, pas un choix.

Quel est le coût d’un comité mal conçu ?

Plus élevé que vous ne le pensez. Une étude juridique montre que les entreprises sans comité formel ont 4,7 fois plus de risques d’être poursuivies pour abus d’IA. Les amendes peuvent atteindre 4 % du chiffre d’affaires selon l’UE. Mais le vrai coût, c’est la perte de confiance. Un seul incident médiatique peut détruire des années de réputation.

Le comité doit-il être permanent ?

Oui. L’IA ne s’arrête pas. Les réglementations évoluent. Les risques changent. Un comité temporaire est un comité mort. Il doit être une structure stable, comme le comité d’audit financier. Mais il peut s’adapter : les membres peuvent changer, les processus peuvent être améliorés. Ce qui ne change pas, c’est son existence.