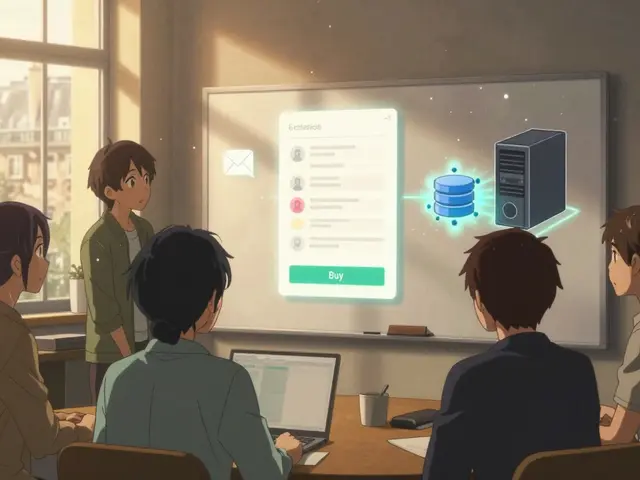

Gestion du trafic et tests A/B pour le déploiement de modèles de langage à grande échelle

Renee Serda juil.. 5 0Apprenez comment la gestion du trafic et les tests A/B permettent de déployer en toute sécurité les modèles de langage à grande échelle, en évitant les erreurs coûteuses et en garantissant la qualité des réponses en production.

Plus d’infos