Architecture logicielle : Comment bâtir des systèmes IA fiables et maintenables

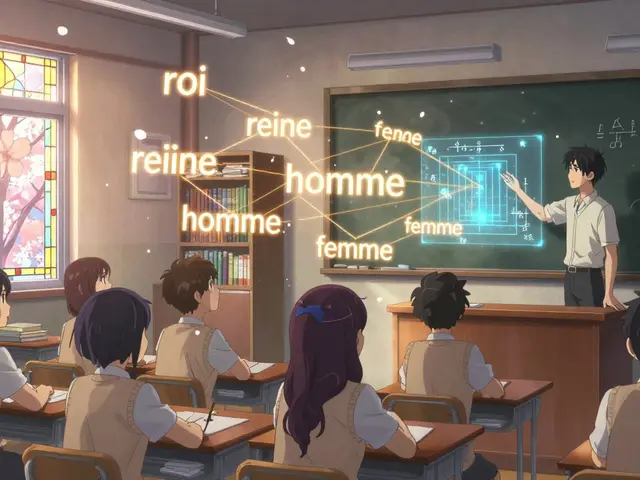

Quand vous déployez un modèle d'IA, ce n'est pas juste une fonction qui s'exécute. C'est une architecture logicielle, la structure organisée qui relie les composants d'un système d'intelligence artificielle pour garantir sa fiabilité, sa sécurité et sa maintenabilité à long terme. Also known as design logiciel pour l'IA, it définit comment les modèles, les données, les APIs et les processus humains interagissent dans un environnement de production.

Une bonne architecture logicielle pour l'IA, c’est ce qui empêche votre modèle de générer du code cassé après une mise à jour, ou de fuir des clés API quand un développeur change de poste. C’est ce qui fait que vos tests de régression détectent les failles avant que le client ne les voie. C’est aussi ce qui vous permet de passer d’un prototype à une solution industrielle sans tout recommencer. Les grandes entreprises ne choisissent pas leurs modèles uniquement pour leur précision — elles choisissent celles qui s’insèrent dans une architecture solide. Et si vous ne pensez pas à l’architecture dès le départ, vous allez finir par payer le prix fort : des pannes coûteuses, des équipes bloquées, et des audits qui révèlent des failles que personne n’avait vues venir.

Vous ne pouvez pas ignorer les LLMOps, les pratiques et outils pour gérer le cycle de vie des grands modèles linguistiques en production, depuis le déploiement jusqu’à la dépréciation. Ce n’est pas un mot à la mode. C’est ce qui sépare les projets qui durent de ceux qui disparaissent après trois mois. Et quand vous parlez de gestion du cycle de vie modèle, le processus structuré qui inclut les mises à jour, les tests, les versions et les retraits des modèles d’IA, vous parlez directement de l’architecture. Un modèle qui n’est pas surveillé, qui n’a pas de plan de sortie, qui n’est pas testé après chaque refactorisation, c’est une bombe à retardement. Ce n’est pas une question de technique — c’est une question de responsabilité.

Les posts que vous allez trouver ici ne parlent pas de théorie abstraite. Ils montrent comment des équipes réelles ont évité les pièges : comment vérifier un agent d’IA sans se perdre dans les garanties formelles, comment faire des tests A/B sur un modèle de langage sans bloquer les utilisateurs, comment choisir entre compresser un modèle ou en changer complètement. Vous trouverez des checklists pour la sécurité du code généré par l’IA, des méthodes pour équilibrer les données multilingues, et des conseils concrets sur la gouvernance du code quand l’IA écrit à votre place. Ce n’est pas une liste de bons conseils — c’est une boîte à outils pour construire des systèmes qui tiennent debout.

Si vous travaillez avec de l’IA en production, vous avez déjà fait face à un problème d’architecture. Ce n’est pas une question de si — c’est une question de quand. Ce que vous allez lire ici, c’est ce qu’il faut faire avant que ce soit trop tard.