BERT : Comprendre le modèle linguistique qui révolutionne l'évaluation des IA

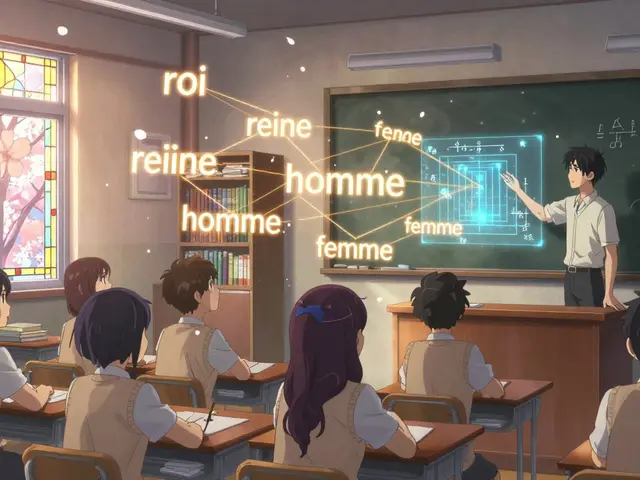

Quand on parle d'BERT, Un modèle de langage pré-entraîné bidirectionnel développé par Google pour comprendre le contexte des mots dans une phrase. Il est aussi connu comme Bidirectional Encoder Representations from Transformers, et il a changé la façon dont on mesure la compréhension des IA. Avant BERT, les modèles lisaient les mots un par un, dans un seul sens. BERT, lui, lit tout le contexte en même temps — avant et après chaque mot. C’est comme si, au lieu de deviner le sens d’un mot isolé, vous voyiez toute la phrase en entier. Cette simple différence a fait exploser la précision des tests d’évaluation.

Le NLP, L’analyse du langage naturel par les machines a longtemps été bloqué par des benchmarks trop simples. BERT a imposé une nouvelle norme : il ne suffit plus de savoir si une IA reconnaît un mot. Il faut savoir si elle comprend une question ambiguë, une négation, ou une référence implicite. C’est pourquoi les benchmarks, Des jeux de tests standardisés pour mesurer la performance des modèles d’IA comme GLUE, SuperGLUE ou MMLU ont été repensés autour de lui. Aujourd’hui, si un modèle ne se teste pas sur des tâches inspirées de BERT, on ne le prend pas au sérieux. Et pour cause : les entreprises qui déployaient des IA pour le service client, la recherche juridique ou la médecine se sont rendu compte que les erreurs venaient souvent d’une mauvaise compréhension du contexte — pas d’un manque de données.

Les posts de cette page ne parlent pas seulement de BERT comme d’un outil technique. Ils montrent comment il influence la gouvernance, la qualité et la fiabilité des IA. Vous y trouverez des analyses sur la façon dont BERT est utilisé pour évaluer les modèles de langage plus récents, comment il aide à détecter les hallucinations, ou encore comment son architecture inspire les nouvelles méthodes d’adaptation de domaine. Vous verrez aussi comment des équipes ont utilisé BERT pour valider des modèles en production, éviter les biais linguistiques, ou comparer des versions de LLM sans avoir à réécrire des tests depuis zéro. Ce n’est pas un modèle du passé. C’est la base sur laquelle on construit encore aujourd’hui l’évaluation éthique et précise des IA.

Si vous travaillez sur l’évaluation des modèles de langage, vous ne pouvez pas ignorer BERT. Même si vous utilisez un modèle plus grand ou plus récent, vous devez comprendre ce qu’il a changé. Parce que derrière chaque score de performance, chaque test de sécurité, chaque audit de conformité, il y a souvent une trace de BERT. Ce que vous allez lire ici, ce ne sont pas des tutoriels pour le faire fonctionner. Ce sont des retours d’expérience sur comment l’utiliser — vraiment — pour dire si une IA est fiable ou pas.