Meta Llama : Le modèle open source qui redéfinit l’évaluation des IA

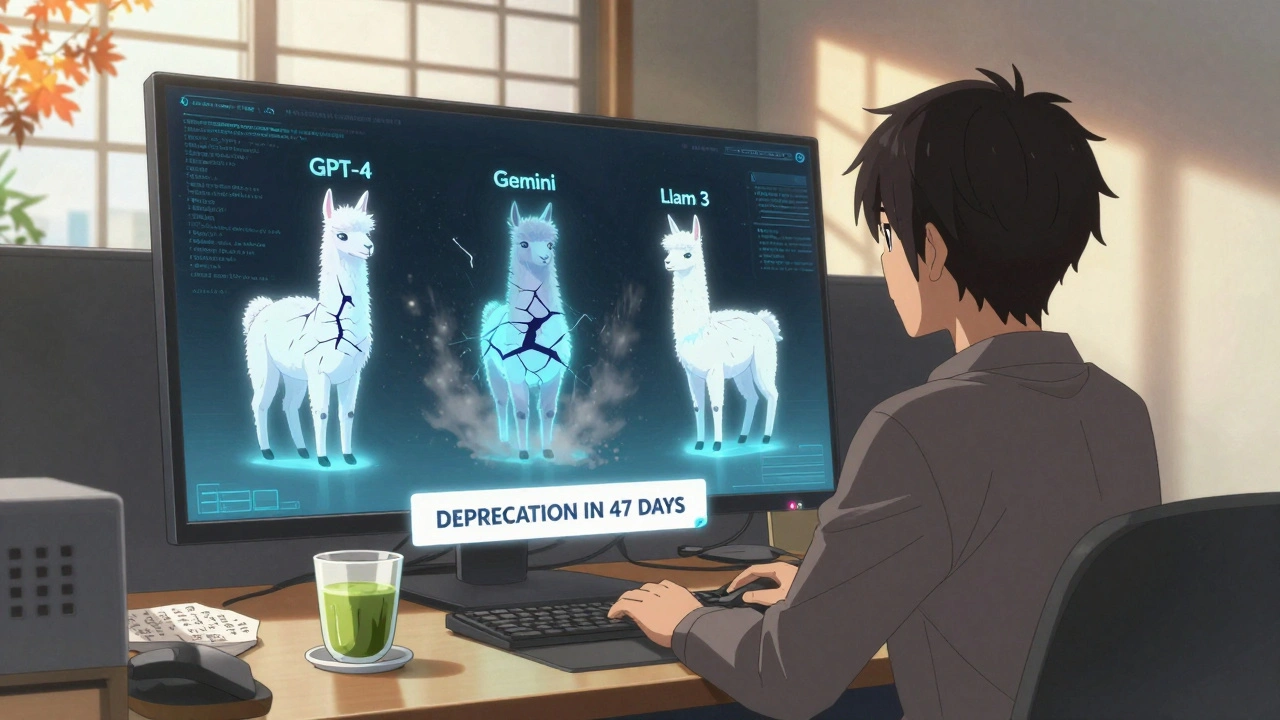

Quand on parle de Meta Llama, une famille de modèles linguistiques open source développés par Meta pour offrir une alternative transparente et performante aux grands modèles propriétaires. Aussi connu sous le nom de Llama 2 ou Llama 3, il est devenu le point de référence pour les équipes qui veulent contrôler leur IA sans dépendre des géants du cloud. Contrairement aux modèles fermés, Llama est conçu pour être audité, ajusté et déployé sur votre infrastructure. C’est pourquoi il est au cœur des discussions sur la fiabilité, l’éthique et la performance des IA.

Les entreprises qui l’utilisent ne se contentent pas de le lancer comme une boîte noire. Elles l’évaluent avec des benchmarks comme MMLU, LiveBench ou des jeux de tests spécifiques à leur domaine. Elles le fine-tunent pour la santé, le droit ou la finance, en s’assurant que les hallucinations sont maîtrisées. Et elles l’auditent pour détecter les biais linguistiques, les fuites de données ou les vulnérabilités dans les prompts. Ce n’est pas juste un modèle. C’est une plateforme d’expérimentation contrôlée.

Vous trouverez ici des guides concrets sur la manière de le comparer à d’autres modèles comme Mixtral ou Phi-3, comment le compresser sans perdre en précision, et comment le déployer avec des tests A/B et un human-in-the-loop pour éviter les erreurs en production. Vous verrez aussi comment les équipes de sécurité vérifient le code généré par Llama, comment les product managers l’utilisent pour construire des prototypes en heures, et pourquoi certains l’abandonnent pour des alternatives plus légères. Ce n’est pas une liste de tutoriels. C’est un recueil d’expériences réelles, avec des erreurs, des gains et des leçons apprises.

Si vous travaillez avec des modèles de langage en production, vous avez déjà rencontré Llama — même si vous ne l’avez pas nommé. Ce que vous allez découvrir ici, c’est comment le maîtriser, pas seulement l’utiliser.