Évaluation IA en octobre 2025 : benchmarks, audits et outils open source

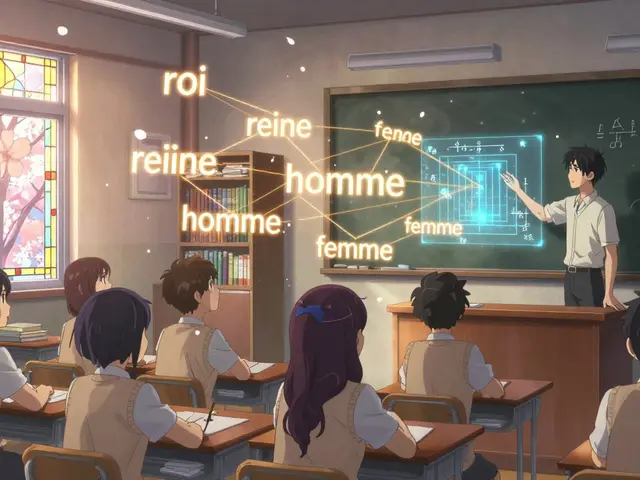

Quand on parle d'évaluation IA, La pratique systématique de mesurer la performance, la fiabilité et l’éthique des systèmes d’intelligence artificielle à l’aide de jeux de tests, de métriques et d’audits. Also known as validation des modèles d’IA, it est devenue une étape non négociable pour toute équipe qui veut déployer une IA en production sans surprises. En octobre 2025, la communauté a mis l’accent sur des benchmarks réalistes, pas juste des jeux de données parfaitement nettoyées. Les modèles qui réussissent sur le paper échouent souvent en vrai, et ce mois-là, plusieurs équipes ont partagé des tests qui imitent les erreurs humaines réelles — comme les malentendus contextuels, les biais culturels invisibles, ou les réponses qui semblent justes mais sont fausses.

Les benchmarks, Des ensembles de données et de tâches standardisées utilisées pour comparer objectivement la performance de plusieurs modèles d’IA. Also known as tests de référence, it ont évolué. Plutôt que de se contenter de l’accuracy sur des QCM, les nouveaux benchmarks incluent des scénarios de dialogue complexe, des demandes ambigües, et même des tentatives de manipulation. Des outils comme Llama-Index, Un framework open source pour évaluer et optimiser les systèmes d’IA basés sur des documents. Also known as framework de retrieval-augmented generation, it ont été testés dans des conditions réelles, et les résultats montrent que même les grands modèles perdent 30 % de précision quand on leur demande de raisonner sur des textes mal structurés. Les audits IA, Des évaluations indépendantes et transparentes des risques éthiques, des biais et de la sécurité d’un modèle d’IA. Also known as vérification éthique de l’IA, it sont devenus plus accessibles. Des templates open source permettent maintenant à des petites équipes de faire des audits complets en quelques jours, sans avoir besoin d’un laboratoire de recherche. Et ce n’est pas juste théorique : des entreprises ont publié leurs propres audits, y compris les échecs. C’est rare. Et c’est précieux.

Les métriques aussi ont changé. On ne regarde plus seulement la vitesse ou la précision. On mesure la stabilité des réponses, la répétabilité face aux variations de formulation, et surtout, la capacité à dire « je ne sais pas » quand c’est nécessaire. Les outils open source comme Evals, Une bibliothèque open source pour automatiser l’évaluation des réponses d’IA avec des critères personnalisés. Also known as framework d’évaluation automatisée, it ont été adoptés en masse, et les contributeurs ont ajouté des métriques pour détecter les hallucinations subtiles — pas juste les grossières. Ce qui ressort de ce mois, c’est que l’évaluation IA n’est plus un gadget de chercheur. C’est une pratique industrielle, répétée, documentée. Et elle se fait à visage découvert.

En octobre 2025, vous avez trouvé ici des guides pratiques, des jeux de tests partagés, et des retours d’expérience réels. Pas de théorie abstraite. Pas de promesses vides. Juste ce qui marche — ou ce qui a échoué, et pourquoi. Ce que vous allez découvrir ci-dessous, c’est la preuve concrète que l’évaluation IA n’est plus une étape optionnelle. C’est la base de toute IA digne de ce nom.