Gestion du cycle de vie modèle : comment piloter les IA de la conception à la production

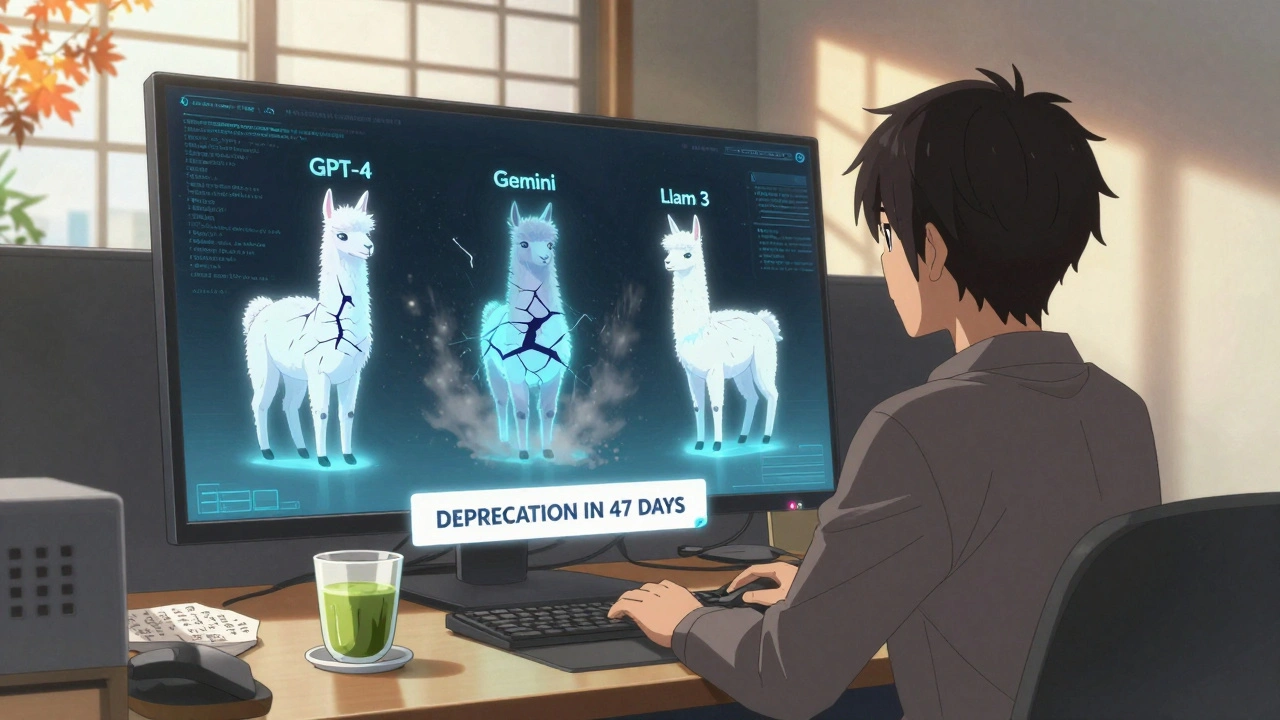

Quand vous déployez un modèle d'IA, vous ne lancez pas juste un code. Vous lancez une gestion du cycle de vie modèle, le processus structuré qui guide un modèle d'intelligence artificielle depuis son idée initiale jusqu'à sa mise à jour ou son retrait définitif. Ce cycle n'est pas une ligne droite — c'est une boucle continue, avec des points de contrôle, des audits, et des décisions critiques que vous ne pouvez pas ignorer. Beaucoup pensent que si le modèle fonctionne en test, il fonctionnera en production. C’est une erreur coûteuse. Les modèles d'IA échouent souvent à cause de ce qu'on oublie après le développement : la gouvernance, la traçabilité, la maintenance, et la réponse aux changements du monde réel.

Le déploiement IA, l'étape où un modèle passe de l'expérimentation à l'utilisation réelle dans des systèmes critiques n'est pas une simple opération technique. C'est une décision organisationnelle. Qui est responsable si le modèle génère une erreur en production ? Quels tests de régression ont été faits après une régénération par l'IA ? Comment gérez-vous les versions ? Les posts de ce site montrent clairement que les équipes qui réussissent ont mis en place des checklists de sécurité, des SLA pour leurs fournisseurs, et des processus de gouvernance modèle, l'ensemble des règles, rôles et outils qui assurent que chaque modèle est contrôlé, documenté et audité. Ce n'est pas de la bureaucratie. C'est de la prévention. Un modèle mal géré peut causer des fuites de données, des biais discriminatoires, ou une perte de confiance totale de vos clients.

Le évaluation IA, la pratique systématique de mesurer la performance, la fiabilité et l'équité d'un modèle dans des scénarios réels ne s'arrête pas au benchmarking. Elle continue pendant toute la vie du modèle. Vous devez vérifier que les performances ne dégradent pas avec le temps, que les données d'entrée n'ont pas changé de distribution, et que les utilisateurs ne trouvent pas de failles dans les prompts. C'est ce que les équipes expérimentées font : elles surveillent, elles testent, elles réajustent. Et elles ne laissent jamais le code généré par l'IA sans revue humaine.

Vous trouverez ici des guides concrets sur comment transformer un prototype vibe coding en composant industriel, comment éviter les modules orphelins, comment équilibrer les données pour les langues rares, et comment mettre en place des tests A/B pour les modèles de langage. Ce n'est pas une collection d'idées théoriques. C'est une boîte à outils pour ceux qui veulent que leurs IA durent, soient fiables, et ne deviennent pas une dette technique impossible à gérer.