Sécurité IA : Protéger les modèles, le code et les données contre les risques réels

Quand on parle de sécurité IA, l’ensemble des pratiques et outils visant à protéger les systèmes d’intelligence artificielle contre les erreurs, les abus et les attaques. Also known as sécurité des systèmes d’IA, it ne se résume pas à bloquer les accès non autorisés — c’est une chaîne entière de garanties, de vérifications et de vigilance continue. La plupart des entreprises pensent que la sécurité, c’est un pare-feu et un mot de passe fort. Mais avec l’IA générative, le danger vient de l’intérieur : un code généré par l’IA qui fuit une clé API, un modèle qui révèle des données personnelles, ou un prompt mal formulé qui ouvre la porte à des injections malveillantes. Ce n’est pas une menace future. C’est ce qui arrive tous les jours dans les équipes qui déployent l’IA sans vérification.

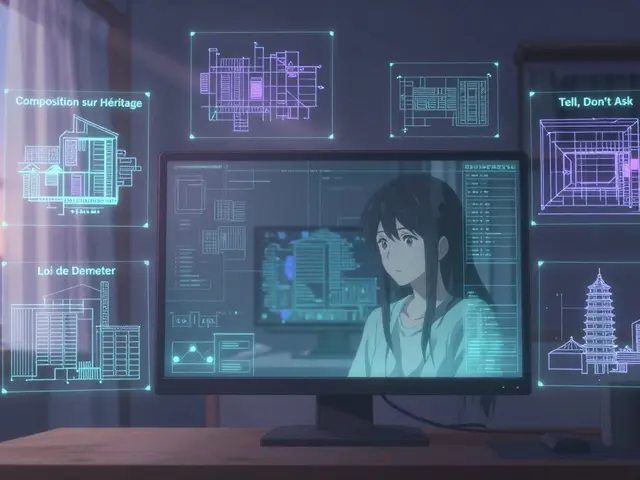

La IA générative, des modèles capables de produire du texte, du code ou des images à partir de simples instructions. Also known as modèles linguistiques génératifs, it est devenue le moteur de la productivité, mais aussi la plus grande source de vulnérabilités invisibles. Si vous utilisez GitHub Copilot ou un outil similaire, vous générez du code — mais qui vérifie qu’il n’y a pas de faille de type OWASP Top 10 ? Qui s’assure que le modèle n’a pas appris à répéter des données privées ? La vie privée différentielle, une technique mathématique qui permet d’entraîner des modèles sans exposer les individus. Also known as DP-SGD, it est la seule méthode fiable pour protéger les données sensibles en santé, finance ou droit. Et pourtant, peu de projets l’appliquent. Les audits AI, eux, sont souvent des checklists vides. Ce qui compte, c’est ce qui est testé en production : les tests de régression après une régénération par l’IA, les revues de code avec checklist spécifique, ou encore les contrôles humains en boucle (human-in-the-loop) pour valider les décisions critiques.

La sécurité IA n’est pas un déploiement ponctuel. C’est une culture. C’est savoir que le code généré par l’IA n’est pas plus sûr qu’un code écrit à la main — il est juste plus vite produit. C’est comprendre que la taille d’un modèle ne garantit pas sa fiabilité. C’est exiger des fournisseurs de modèles qu’ils fournissent des preuves, pas des promesses. Ce que vous trouverez ici, ce ne sont pas des théories. Ce sont des méthodes concrètes utilisées par des équipes qui ont eu des incidents, des failles, des audits échoués. Des checklists pour vérifier le code, des cadres pour évaluer les risques, des stratégies pour intégrer la sécurité sans ralentir le développement. Vous verrez comment les grandes entreprises gèrent les mises à jour de modèles, comment on protège les données en entraînement, et pourquoi un simple prompt mal écrit peut causer une fuite de données. Tout ce que vous lisez ici vient de l’expérience réelle. Pas de jargon. Pas de fluff. Juste ce qui fonctionne.