IA générative : Comment évaluer, sécuriser et déployer les modèles qui transforment le code et les contenus

Quand vous utilisez une IA générative, un système d’intelligence artificielle capable de créer du texte, du code ou des images à partir de simples instructions. Also known as modèle de langage large, it est la base de outils comme ChatGPT, GitHub Copilot ou Claude, et elle change la façon dont les équipes tech construisent des logiciels. Ce n’est pas juste une aide à la rédaction — c’est un nouveau collaborateur. Mais comme tout collaborateur, il faut savoir l’évaluer, le sécuriser et le gérer au quotidien. Sinon, vous finissez avec du code qui marche… mais qui ouvre une faille de sécurité, ou un contenu qui semble juste… mais qui ment.

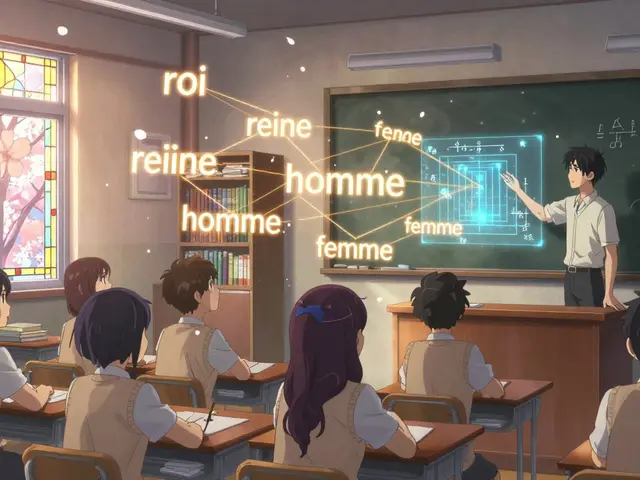

Les modèles linguistiques, des systèmes d’IA formés sur des milliards de mots pour comprendre et générer du langage, sont au cœur de cette révolution. Mais leur taille (7 milliards ou 2 billions de paramètres) ne dit pas tout. Ce qui compte, c’est comment ils ont été entraînés, quelles données ils ont vues, et surtout : comment ils réagissent dans votre contexte spécifique. Un modèle qui excelle en anglais peut être nul en français, ou ne pas comprendre les termes juridiques de votre métier. C’est pourquoi l’évaluation IA, l’ensemble des méthodes pour mesurer la fiabilité, la précision et l’éthique des modèles, n’est plus un luxe — c’est une obligation. Les scores publics comme MMLU ou LiveBench sont utiles, mais ils ne vous disent pas si le modèle va bien fonctionner dans votre CRM ou votre application médicale.

Et puis il y a le code généré par IA, le code écrit par des outils comme Copilot ou CodeLlama, souvent utilisé en vibe coding pour accélérer le développement. Il est rapide, souvent fonctionnel… et souvent dangereux. Il oublie les validations, expose des clés API, ou crée des boucles infinies. Personne ne vérifie ce code comme on vérifiait un code écrit à la main. Pourtant, les failles sont là. C’est pourquoi les checklists de sécurité, les tests de régression, et les modèles de propriété du code sont devenus indispensables. Qui est responsable quand ce code plante en production ? L’ingénieur ? L’outil ? L’entreprise ? La réponse est simple : vous, si vous ne mettez pas des règles en place.

Vous trouverez ici des guides concrets sur comment équilibrer les données pour les modèles multilingues, comment choisir entre compresser un modèle ou en changer, comment écrire des prompts qui évitent les hallucinations, et comment gérer les mises à jour sans casser vos applications. Pas de théorie abstraite. Pas de jargon inutile. Juste des méthodes testées, des erreurs à éviter, et des outils open source que les équipes utilisent déjà en production. Que vous soyez développeur, architecte ou responsable qualité, ce qui suit vous aidera à utiliser l’IA générative sans vous mettre en danger.